使用 Ollama 和 Continue 创建你的 AI-Powered Coding Copilot

编辑器内的一个完全开源的 AI 代码助手

Continue 可以让您使用开源 LLM 直接在 Visual Studio Code 和 JetBrains 中轻松创建自己的编码助手。所有这些都可以完全在您自己的笔记本电脑上运行,或者将 Ollama 部署在服务器上,以根据您的需求远程支持代码完成和聊天体验。

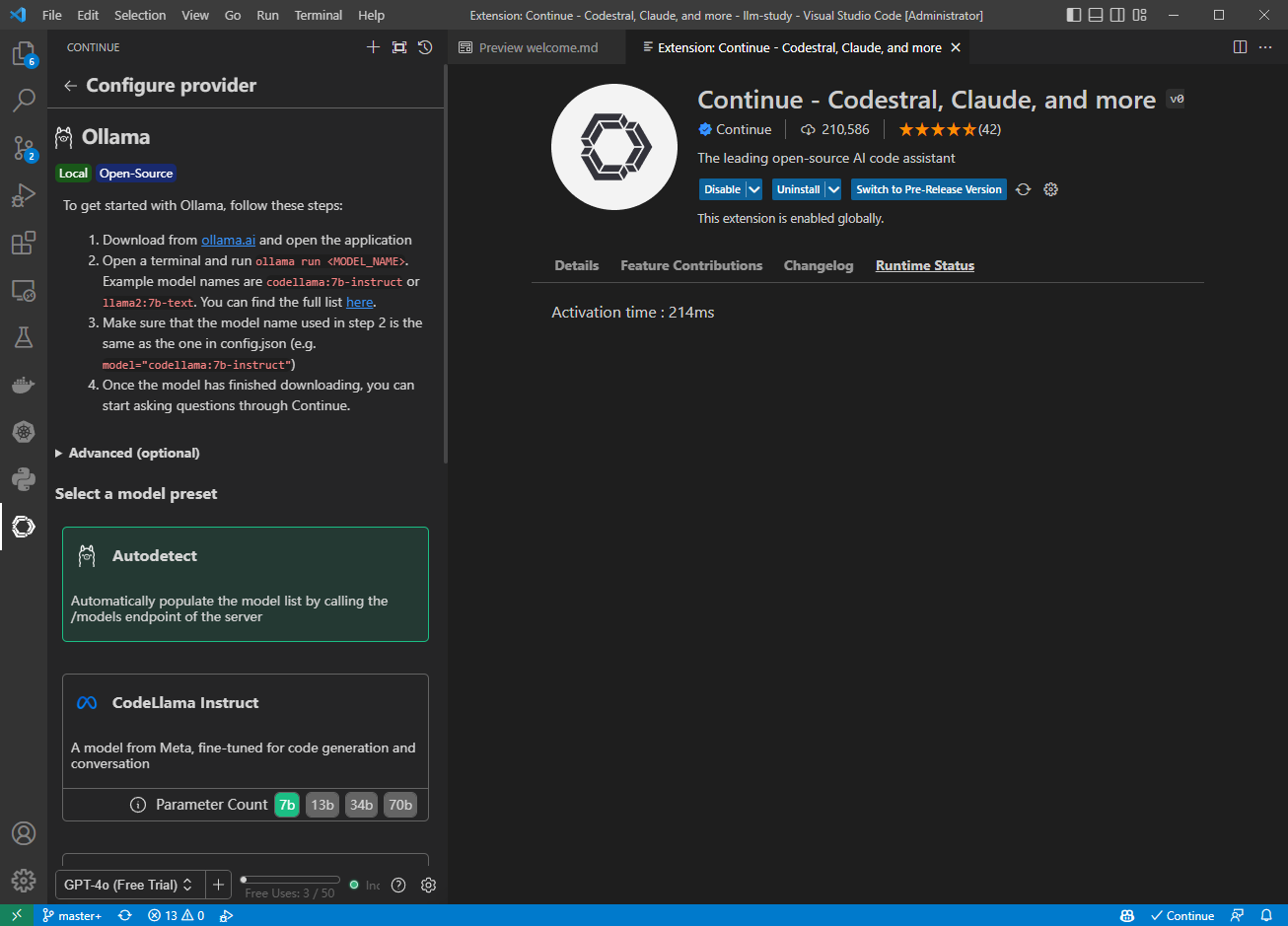

要进行设置,您需要安装

- 继续使用 VS Code 或 JetBrains

- 适用于 macOS、Linux 或 Windows 的Ollama

下载完成后,我们建议您探索以下内容:

尝试 Mistral AI 的 Codestral 22B 模型进行自动完成和聊天

到目前为止,Codestral是我们目前最喜欢的模型,它既能自动完成,又能聊天。该模型展示了 LLM 在编程任务方面的改进。但是,由于它有 22B 参数和非生产许可证,因此需要相当多的 VRAM,只能用于研究和测试目的,因此它可能不是日常本地使用的最佳选择。

a. 在终端中下载并运行 Codestral,运行方式如下:

ollama run codestralb. 点击继续右下角的齿轮图标,打开config.json并添加

{

"models": [

{

"title": "Codestral",

"provider": "ollama",

"model": "codestral"

}

],

"tabAutocompleteModel": {

"title": "Codestral",

"provider": "ollama",

"model": "codestral"

}

}

使用 DeepSeek Coder 6.7B 进行自动完成,使用 Llama 3 8B 进行聊天

根据您机器上的 VRAM 数量,您可能能够利用 Ollama 运行多个模型和处理多个并发请求的能力,方法是使用DeepSeek Coder 6.7B进行自动完成,使用Llama 3 8B进行聊天。如果您的机器无法同时处理这两者,请分别尝试,然后决定您是喜欢本地自动完成还是本地聊天体验。然后,您可以使用远程托管或 SaaS 模型来获得另一种体验。

- a. 在终端中下载并运行 DeepSeek Coder 6.7B,运行方式如下:

ollama run deepseek-coder:6.7b-base- b. 在另一个终端窗口中下载并运行 Llama 3 8B,运行

ollama run llama3:8b- c. 点击继续右下角的齿轮图标打开

config.json并添加

{

"models": [

{

"title": "Llama 3 8B",

"provider": "ollama",

"model": "llama3:8b"

}

],

"tabAutocompleteModel": {

"title": "DeepSeek Coder 6.7B",

"provider": "ollama",

"model": "deepseek-coder:6.7b-base"

}

}使用 nomic-embed-text Ollama 嵌入来增强@codebase

Continue 内置了

@codebase上下文提供程序,可让您自动从代码库中检索最相关的代码片段。假设您已经设置了聊天模型(例如Codestral、Llama 3),那么您可以通过Ollama和LanceDB的嵌入将整个体验保持在本地。截至目前,我们建议使用nomic-embed-text嵌入。

- a. 在终端中运行下载 nomic-embed-text

ollama pull nomic-embed-text- b. 点击继续右下角的齿轮图标打开config.json并添加

{

"embeddingsProvider": {

"provider": "ollama",

"model": "nomic-embed-text"

}

}- c. 根据代码库的大小,索引可能需要一些时间,然后您可以向它提问,系统会自动找到重要的代码库部分并将其用于回答(例如“@codebase Llama 3 的默认上下文长度是多少?”)

基于你的开发数据对 StarCoder 2 进行微调并将其推送到 Ollama 模型库

使用 Continue 时,您会自动生成有关如何构建软件的数据。默认情况下,此开发数据会保存到.continue/dev_data您的本地机器上。当与您最终提交的代码结合时,它可用于改进您或您的团队使用的 LLM(如果您允许)。例如,您可以使用团队接受的自动完成建议来微调 StarCoder 2 等模型,以便为您提供更好的建议。

通过 Continue 使用 @docs 提问来 了解更多关于 Ollama 的信息

Continue 还内置了@docs上下文提供程序,可让您索引和检索来自任何文档站点的片段。假设您已经设置了聊天模型(例如 Codestral、Llama 3),您可以通过提供 GitHub 上的 Ollama README 链接并提出问题以了解更多信息,从而让整个体验保持本地化。

a.在聊天侧栏中输入

@docs文字,选择“添加文档”,将“https://github.com/ollama/ollama”复制并粘贴到 URL 字段中,然后在标题字段中输入“Ollama”b. 它应该快速索引 Ollama README,然后您可以提出问题,它会自动找到重要部分并将其用于答案(例如“@Ollama 我如何运行 Llama 3?”)

Continue 是领先的开源 AI 代码助手。您可以连接任何模型和任何上下文,在

VS Code和JetBrains中构建自定义自动完成和聊天体验

轻松理解代码部分

cmd+L(MacOS)/ ctrl+L(Windows)

按 Tab 键自动完成代码建议

tab(MacOS)/ tab(Windows)

重构您正在编码的函数

cmd+I(MacOS)/ ctrl+I(Windows)

询问有关你的代码库的问题

@codebase(MacOS)/ @codebase(Windows)

快速使用文档作为上下文

在 VSCode 中将您的模型配置为 Copilot

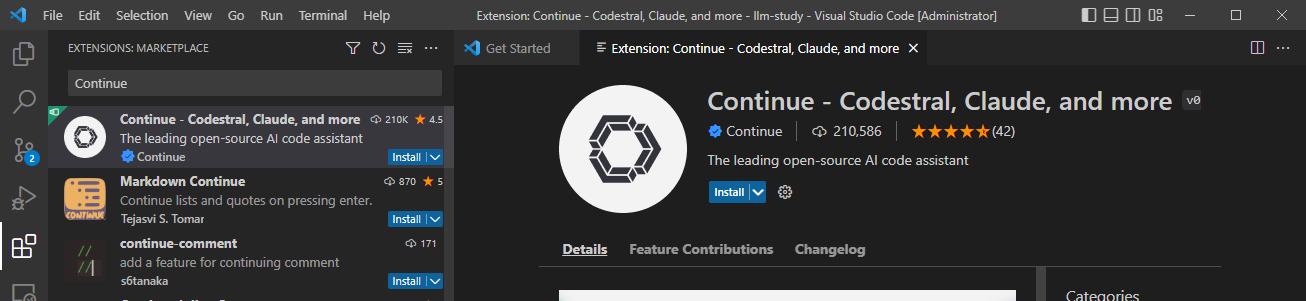

VSCode 安装 Continue 插件,使用浏览器打开 Continue VSCode extension,单击 Install,

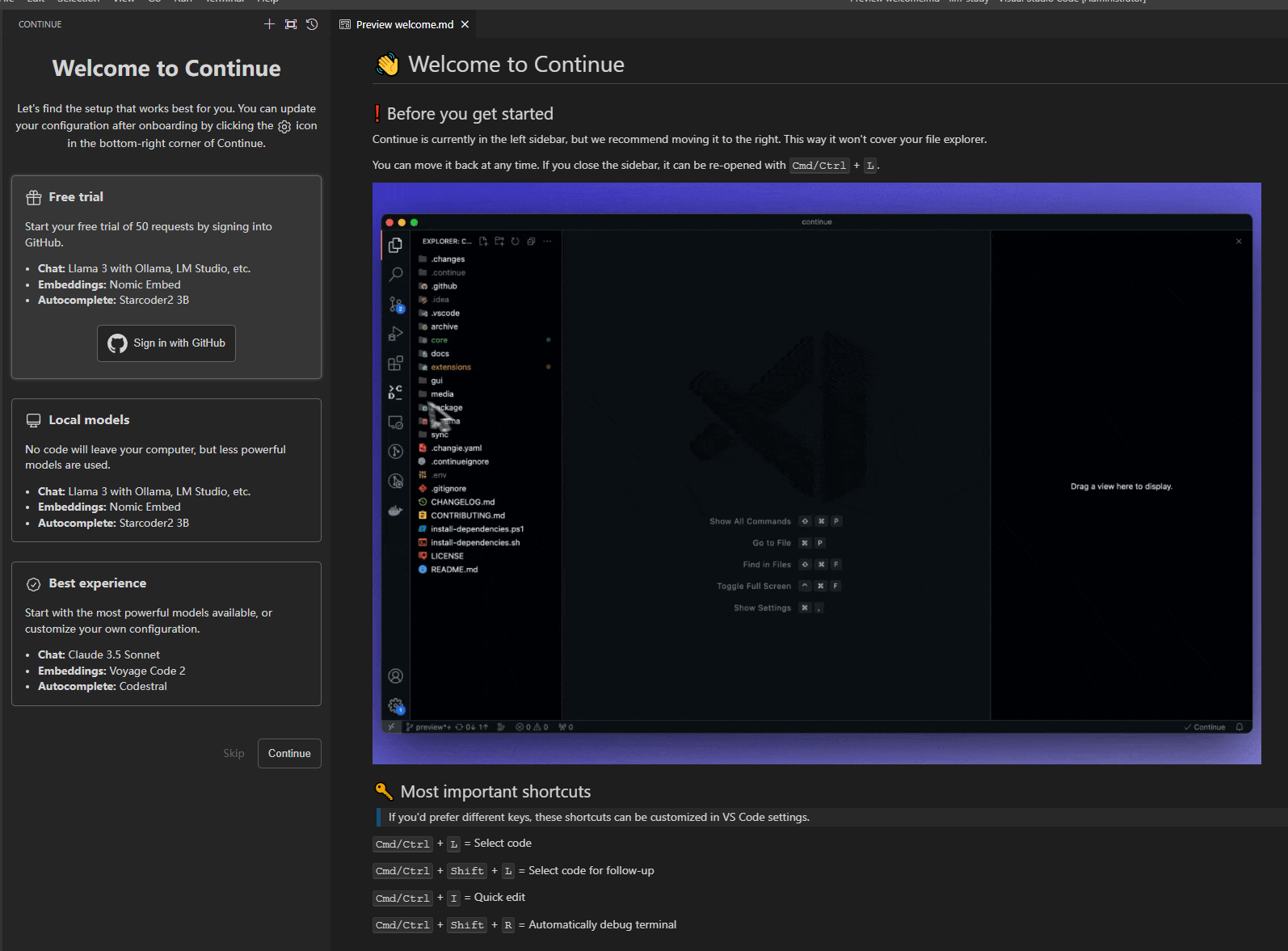

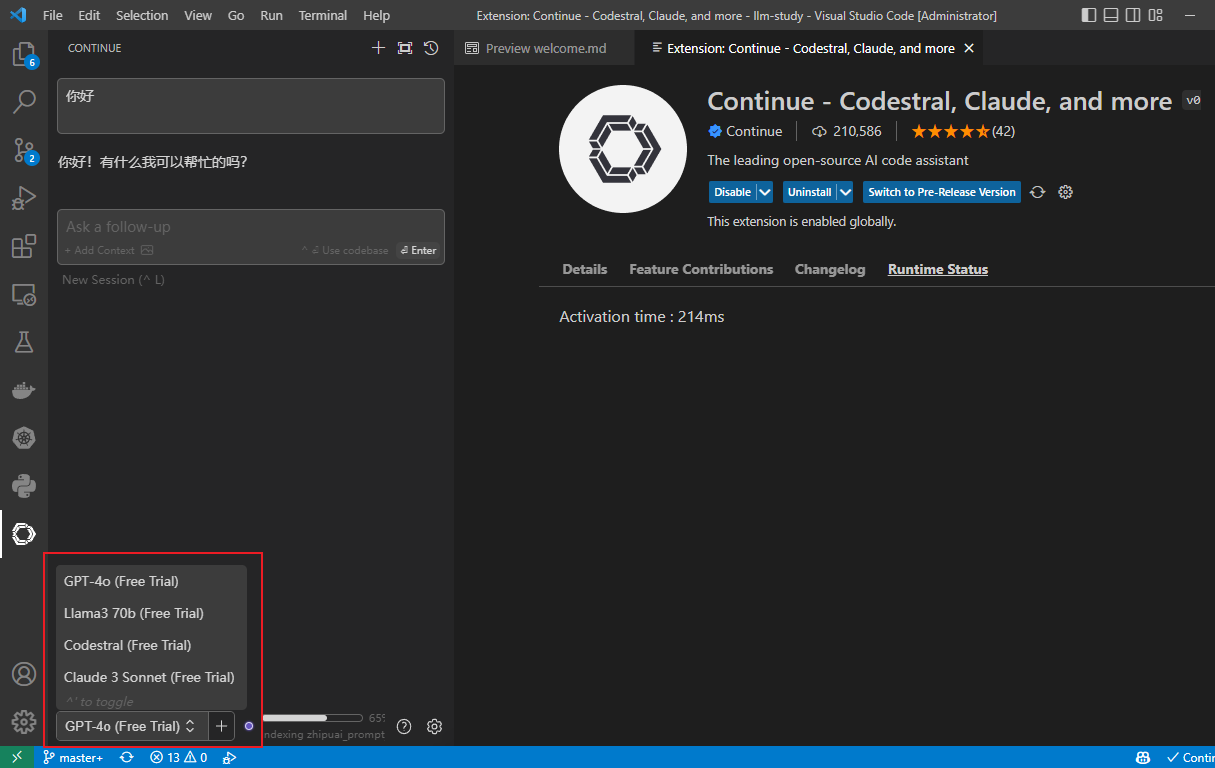

安装完成后,自动进入操作界面,使用你的 GitHub 账户登录,登录后可获得 50次 免费试用:

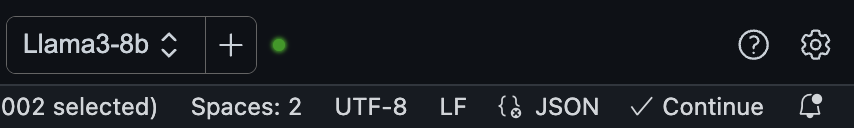

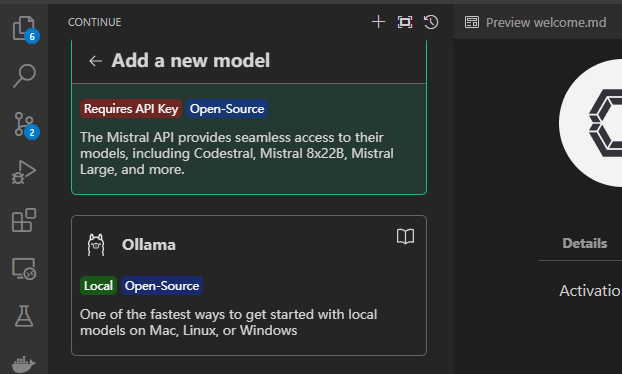

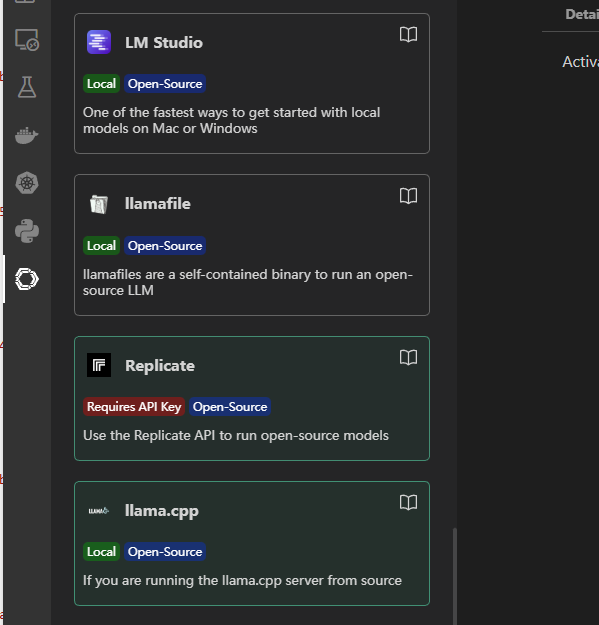

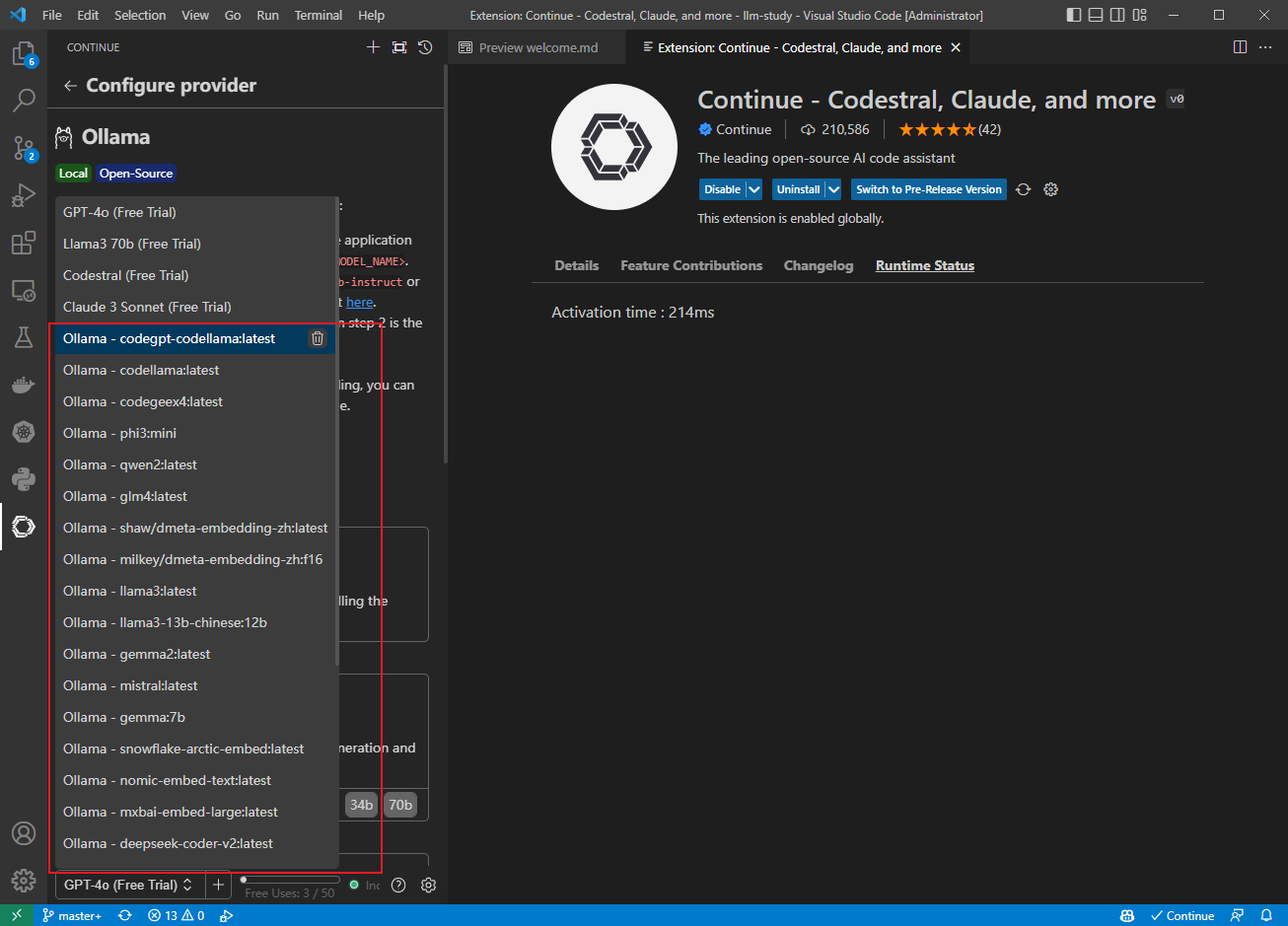

默认有4个免费试用的模型,这里可以点击 + 号添加模型

,选择 Ollama

https://ollama.com/blog/continue-code-assistant

最后编辑:Jeebiz 更新时间:2025-12-13 10:17