使用 Ollama 和 CodeGPT 创建你专属的自定义 Copilot

Ollama 是一款人工智能工具,可让您在自己的计算机上轻松设置和运行大型语言模型。

使用 Ollama,您可以使用 Mistral、Llama 2 或 Gemma 等非常强大的模型,甚至可以制作自己的自定义模型。它适用于 macOS、Linux 和 Windows,因此几乎任何人都可以使用它。

下载Ollama

访问 https://ollama.com/download 获取 Ollama

下载模型

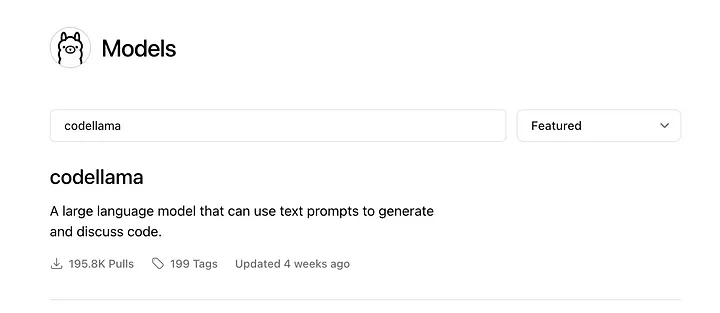

要在计算机上运行 AI 模型,首先需要从 Ollama 服务器下载该模型。有关可用模型的完整列表,请访问以下链接:https://ollama.com/library

您可以搜索特定型号或按类别排序。

在本教程中,我们将下载 CodeLlama 模型,这是由 Meta 创建的专门编程模型(https://github.com/facebookresearch/codellama)

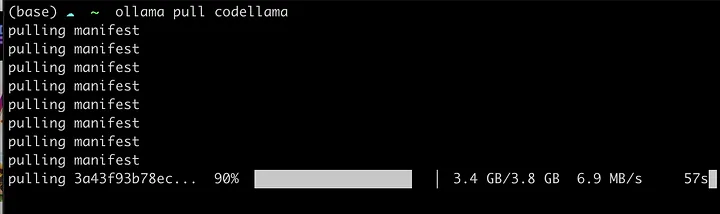

要下载模型,请运行以下命令:

ollama pull codellama模型下载将开始,所以现在,你需要耐心等待🙄

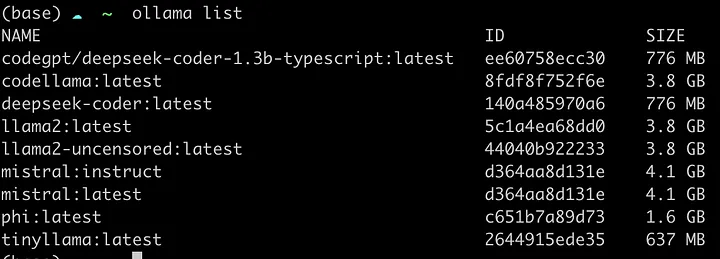

列出模型

如果您想显示已下载的模型列表,请执行以下命令:

ollama list

运行模型

现在您已经下载了模型,您可以通过执行以下命令在终端中运行它们:

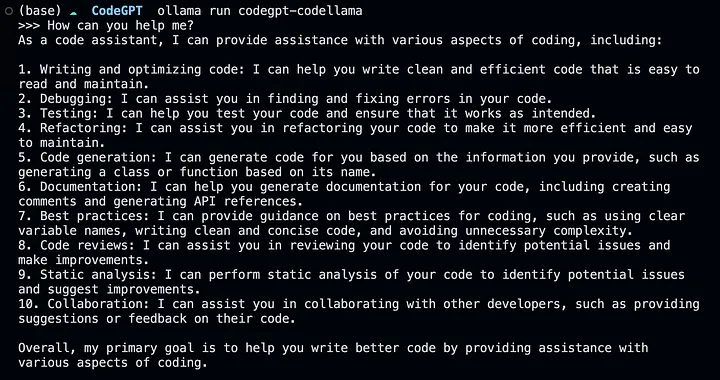

ollama run codellama测试模型;你应该直接在终端中看到响应

如果您收到回复,则表示该模型已安装并准备在您的计算机上使用。恭喜!

模型文件

Modelfile 是使用 Ollama 创建和共享模型的蓝图。使用 Modelfile,您可以为模型创建自定义配置,然后将其上传到 Ollama 以运行它。

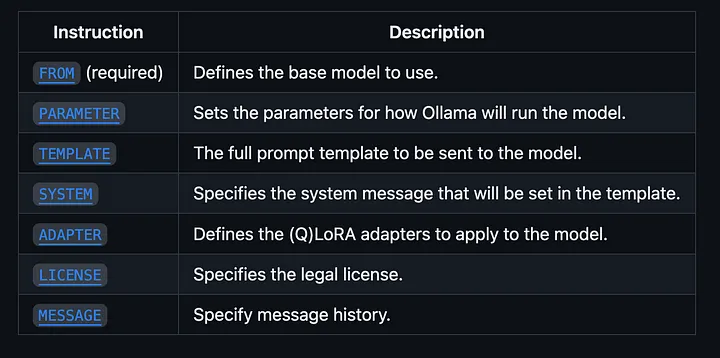

这些是您可以在 Modelfile 中配置的参数:

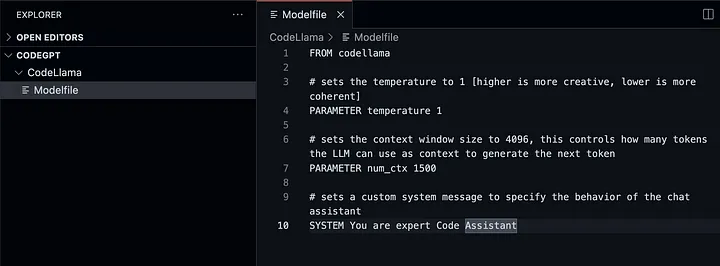

创建模型文件

现在,让我们通过选择 CodeLlama 模型来创建一个 Modelfile,以便将其作为 CodeGPT 中的自定义模型加载。

创建一个名为 CodeLLama 的文件夹,然后创建一个名为 Modelfile 的文件,添加以下代码:

FROM codellama

# sets the temperature to 1 [higher is more creative, lower is more coherent]

# 将温度设置为 1 [越高越有创意,越低越连贯]

PARAMETER temperature 1

# sets the context window size to 1500, this controls how many tokens the LLM can use as context to generate the next token

# 将上下文窗口大小设置为 1500,这控制了 LLM 可以使用多少个 token 作为上下文来生成下一个 token

PARAMETER num_ctx 1500

# sets a custom system message to specify the behavior of the chat assistant

# 设置自定义系统消息来指定聊天助手的SYSTEM行为;你是代码助手专家

#SYSTEM You are expert Code Assistant

SYSTEM 你是代码助手专家

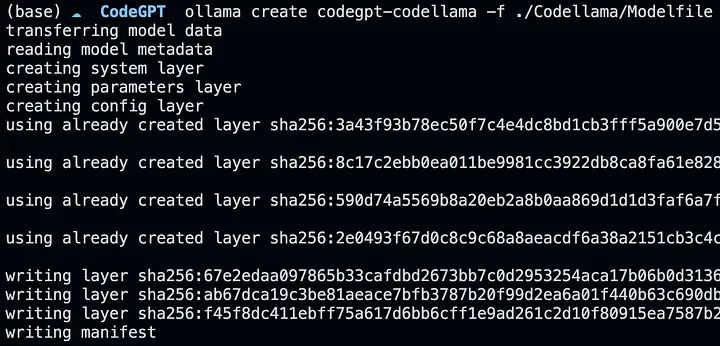

运行以下命令激活此新配置。在本例中,我们将创建配置模型 codegpt-codellama

ollama create codegpt-codellama -f ./Codellama/Modelfile

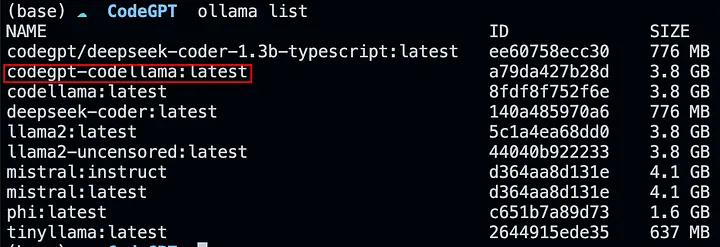

如果我们运行ollama list,我们将能够看到新模型已经在我们的列表中。

ollama run codegpt-codellama 使用我们设置为代码助手的模型来测试这个新配置。

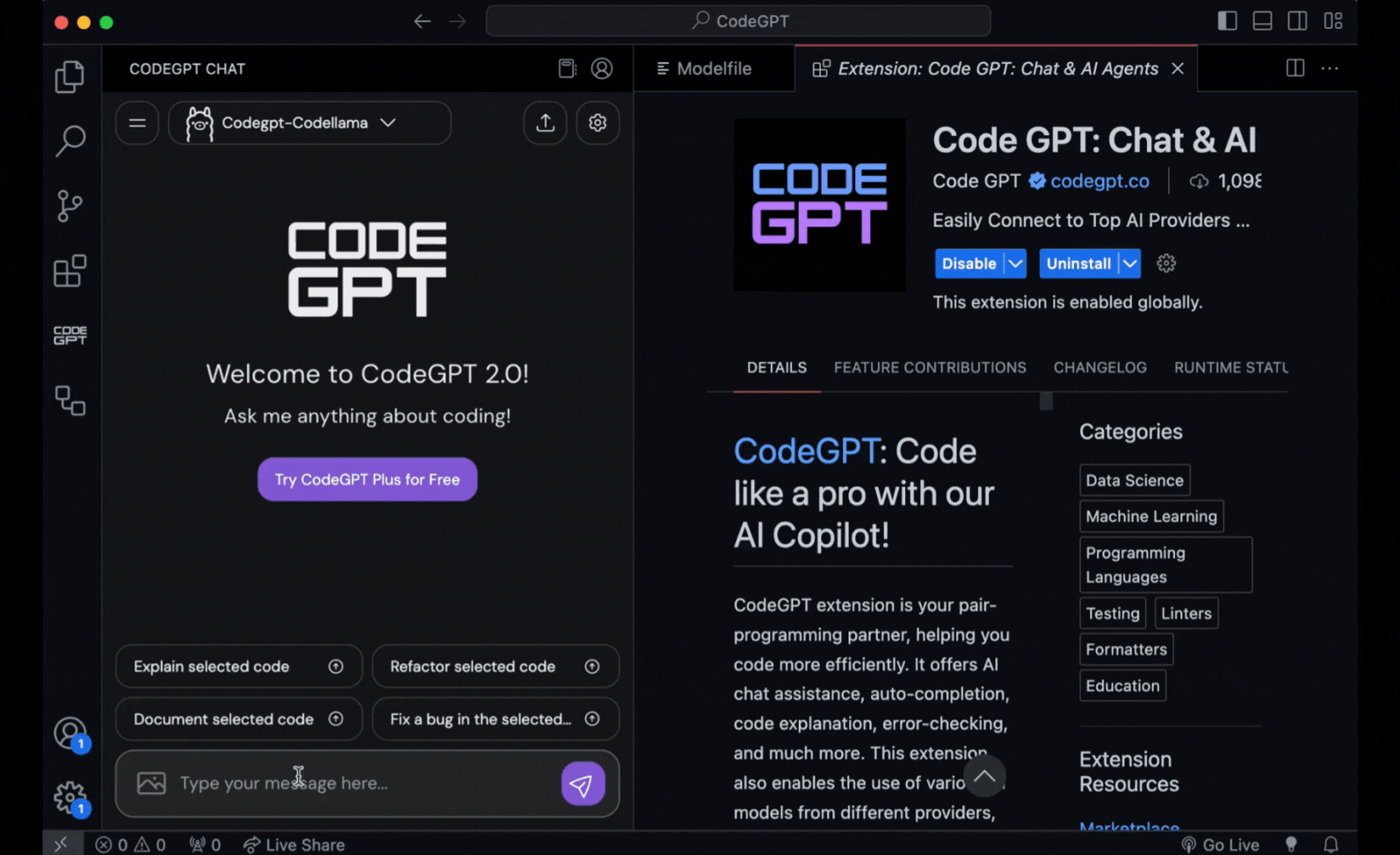

在 VSCode 中将您的模型配置为 Copilot

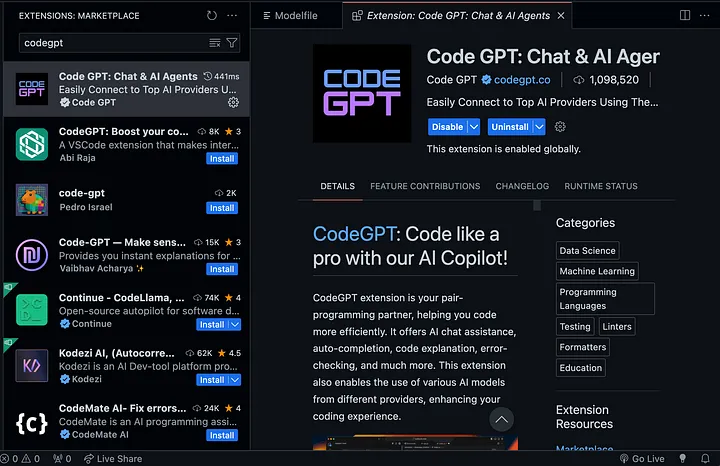

一旦您的新模型配置启动并运行,让我们在 Visual Studio Code 中使用 CodeGPT 扩展将其与 Ollama 连接。

从 VSCode 中的市场选项卡安装 CodeGPT。

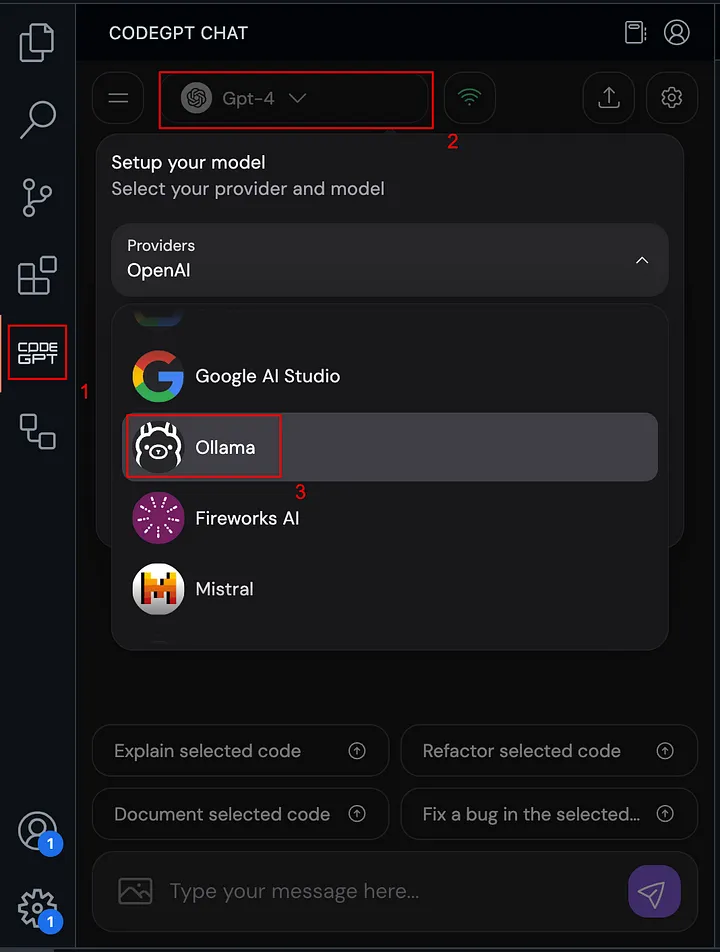

在扩展菜单中,单击 CodeGPT 图标,然后展开提供商选择器并选择 Ollama

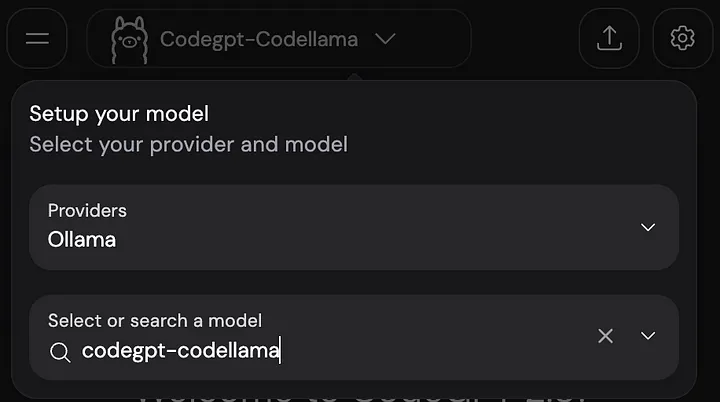

选择提供商后,在模型选择器中输入我们刚刚创建的模型的名称,在本例中为 codegpt-codellama

就是这样!🙌

现在,您已经拥有了这个由您创建的新模型,可以将其用作 Visual Studio Code 中的编程助手 Copilot,这要感谢 Ollama 和 CodeGPT

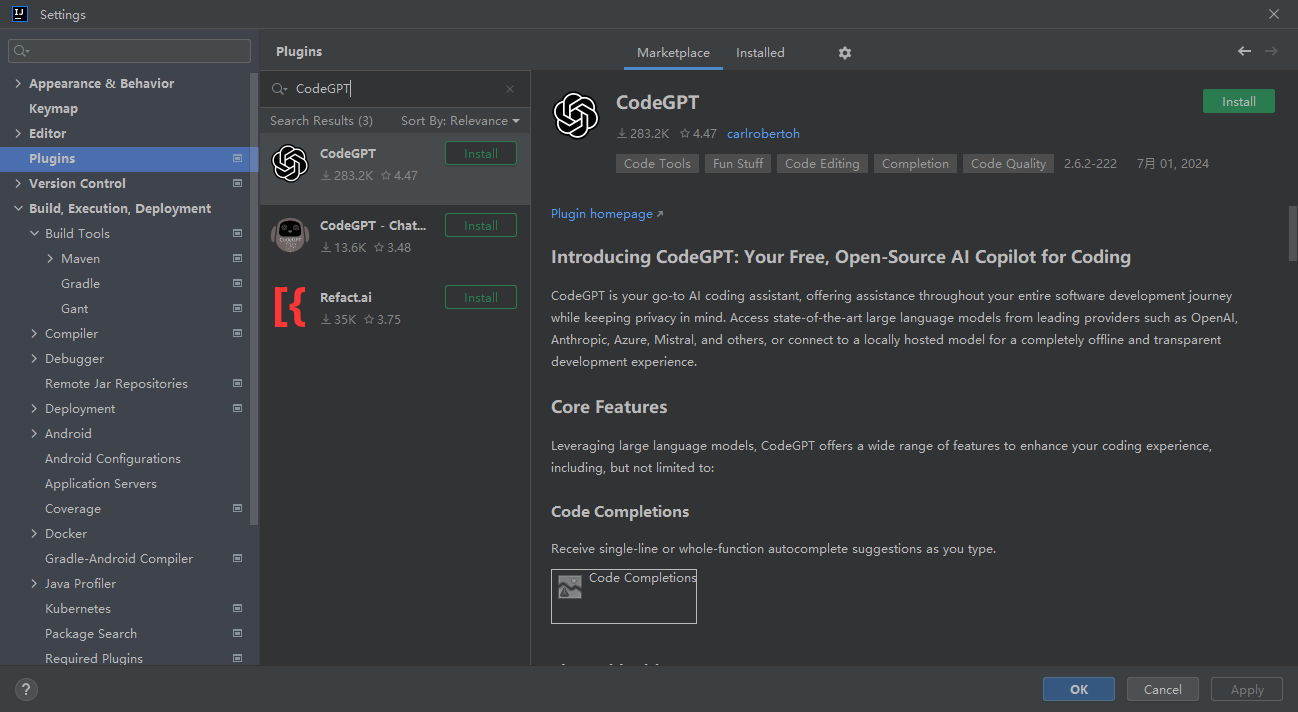

在 IntelliJ IDEA 中将您的模型配置为 Copilot

我们还可以在 IntelliJ IDEA 中使用 CodeGPT 扩展将其与 Ollama 连接。

从 IntelliJ IDEA 中的 设置-> 插件 项卡安装 CodeGPT。

最后编辑:Jeebiz 更新时间:2025-12-13 10:17