Ollama 环境安装:Ollama 在 Windows 系统下的安装及设置

Ollama 现已在 Windows 上提供预览版,让您能够以全新的原生 Windows 体验拉取、运行和创建大型语言模型。Windows 上的 Ollama 包括内置 GPU 加速、完整模型库访问权限以及包括 OpenAI 兼容性的 Ollama API 。

- 官方网站:https://ollama.com/

硬件加速

Ollama 使用 NVIDIA GPU 以及现代 CPU 指令集(如 AVX 和 AVX2,如果可用)来加速运行模型。无需配置或虚拟化!

完全访问模型库

完整的 Ollama 模型库可在 Windows 上运行,包括视觉模型。运行LLaVA 1.6等视觉模型时,可以将图像拖放到 ollama run 消息中。

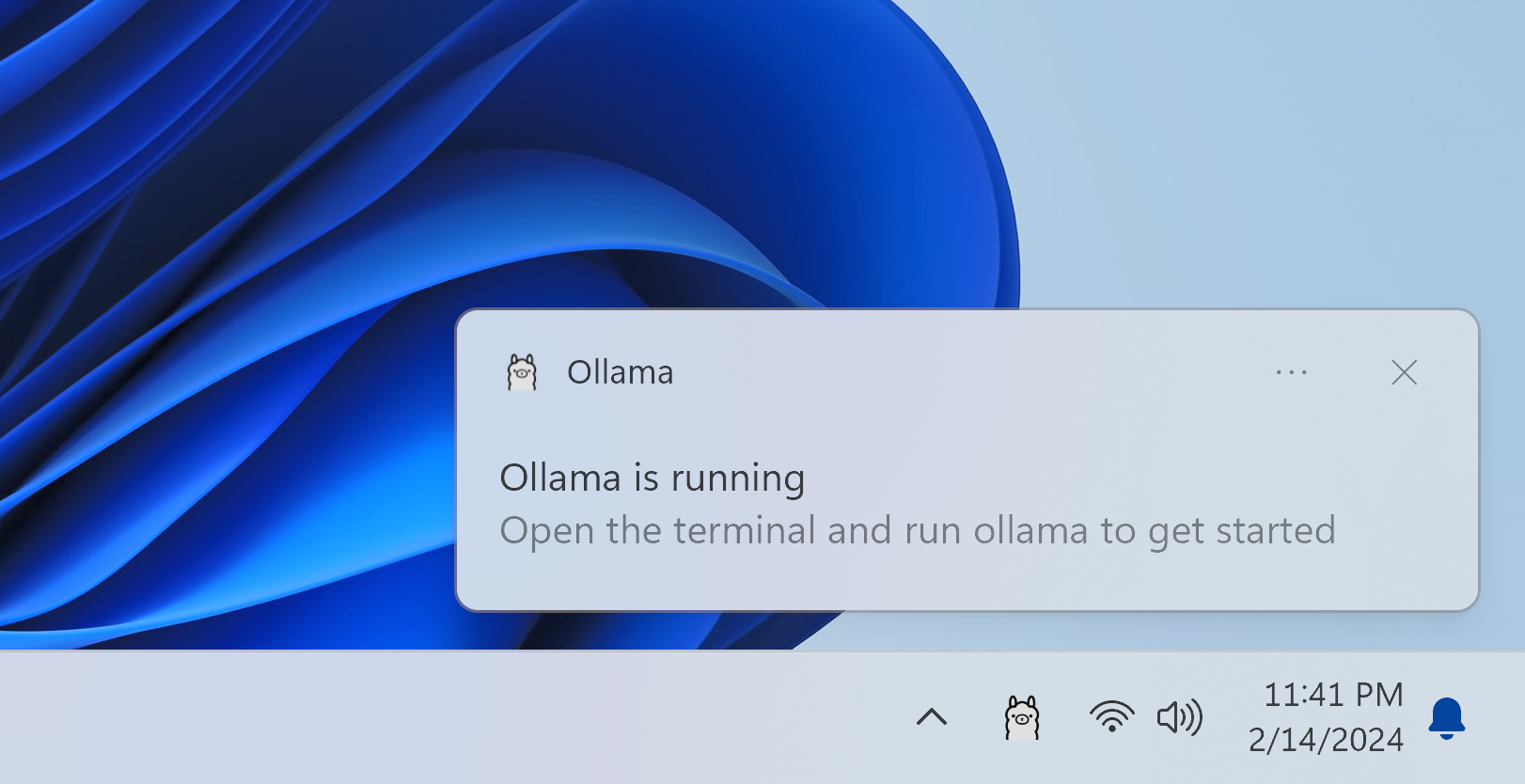

始终开启 Ollama API

Ollama 的 API 自动在后台运行,服务于http://localhost:11434。工具和应用程序无需任何额外设置即可连接到它。

例如,以下是使用 PowerShell 调用 Ollama 的 API 的方法:

(Invoke-WebRequest -method POST -Body '{"model":"llama2", "prompt":"Why is the sky blue?", "stream": false}' -uri http://localhost:11434/api/generate ).Content | ConvertFrom-jsonWindows 上的 Ollama 也支持与其他平台相同的 OpenAI 兼容性,从而可以通过 Ollama 将为 OpenAI 构建的现有工具与本地模型一起使用。

下载安装

要开始使用 Windows 预览版中的 Ollama:

- 在 Windows 上,下载 Ollama

- 双击安装程序,

OllamaSetup.exe - 安装后,打开您喜欢的终端并运行

ollama run llama3以运行模型

环境设置

在 Ollama 中,环境变量赋予了我们调整和定制这个强大工具的能力。就像一位指挥家调整乐队的每一件乐器,通过精心设置这些环境变量,我们可以让Ollama完美地适应我们的需求,奏出最和谐的数据交响曲。

可以设置的环境变量有哪些?

- OLLAMA_HOST:设置网络监听端口。当我们设置

OLLAMA_HOST为0.0.0.0时,就相当于开放端口,可以让人意外部网络访问。 - OLLAMA_MODELS:设置模型的存储路径。当我们设置

OLLAMA_MODELS=E:\Ollama\models,就相当于给模型们在E盘建了一个仓库,让它们远离C盘。 - OLLAMA_KEEP_ALIVE: 它决定了我们的模型们可以在内存里的存活时间。设置

OLLAMA_KEEP_ALIVE=24h,就好比给模型们装上了一块超大容量电池,让它们可以连续工作24小时,时刻待命。 - OLLAMA_PORT:用来修改ollama的默认端口,默认是

11434,可以在这里改为你想要的端口。 - OLLAMA_NUM_PARALLEL:限制了Ollama可以同时加载的模型数量。

- OLLAMA_MAX_LOADED_MODELS:可以确保系统资源得到合理分配。

环境变量的设置看似简单,但却是驾驭 Ollama 的关键。它们让 Ollama 从一个普通的工具,变成了我们可以随心调教的得力助手。

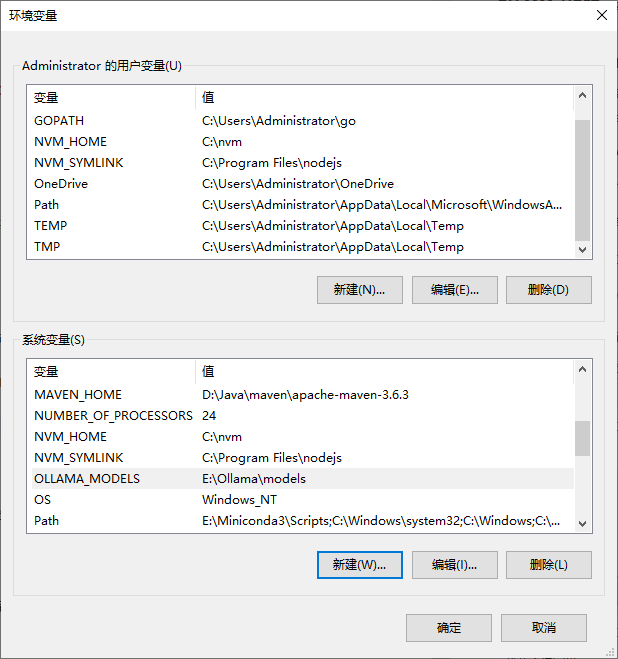

Windows 系统中如何设置 Ollama 环境变量

这里我们以OLLAMA_HOST和OLLAMA_MODELS两个环境变量为例,开放外部端口访问和自定义模型存储路径

- 1、右键点击

此电脑,点击属性 - 2、点击

高级系统设置 - 3、点击

环境变量,进入环境变量设置界面

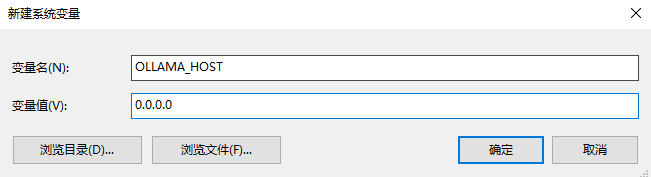

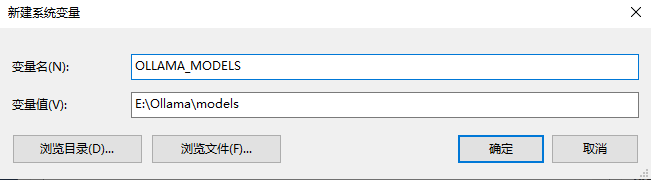

- 4、在下面的系统变量内点击新建;输入变量名

OLLAMA_HOST,变量值0.0.0.0,确定

- 5、再下面的系统变量内点击新建;输入变量名

OLLAMA_MODELS,变量值E:\Ollama\models,确定

- 6、点击环境变量设置界面

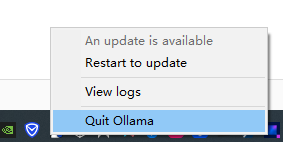

确定按钮,设置完成。 - 7、退出 Ollama 服务,然后重启

验证 Ollama 环境变量是否有效

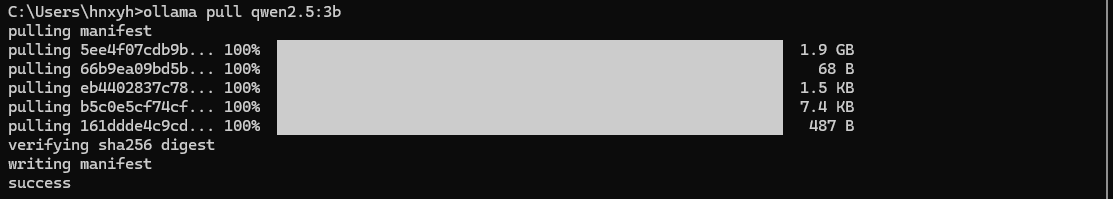

- 1、拉取一个本地没有的模型,例:

ollama pull qwen2.5:3b,等待拉取成功。

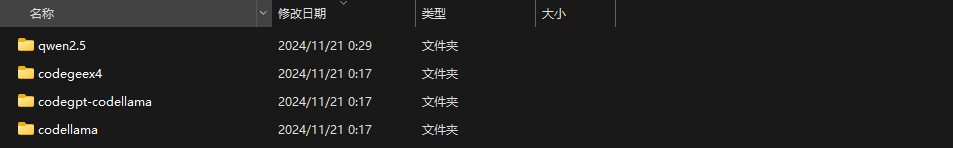

- 2、进入

E:\Ollama\models目录,查看刚拉取的新模型已经存在

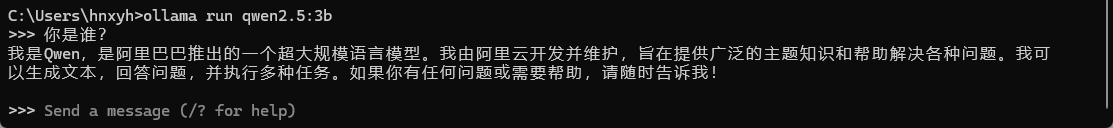

- 3、使用

ollama run qwen2.5:3b命令运行模型并进行对话

参考资料:

- Windows preview:https://ollama.com/blog/windows-preview

作者:Jeebiz 创建时间:2024-06-11 23:37

最后编辑:Jeebiz 更新时间:2025-12-13 10:17

最后编辑:Jeebiz 更新时间:2025-12-13 10:17