Ollama 快速入门:快速开始(Quick start)

前文中我们已经对Ollama有了基本的了解,并且已经在本地电脑上安装好了Ollama服务。我们现在可以开始快速体验 Ollama 的强大功能了。以下是如何快速运行一个模型并与其进行交互的基本步骤。

下载并运行模型

选择模型

Ollama 提供了丰富的模型库,你可以根据需要选择不同的模型。例如,我们可以选择运行 Qwen 2.5 模型。

运行模型

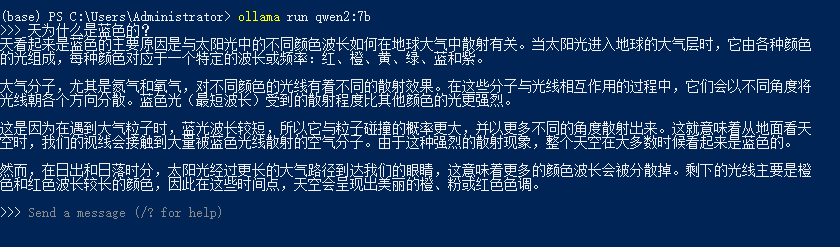

使用以下命令下载并运行 Qwen 2.5 模型:

ollama run qwen2.5:7b这条命令会从 Ollama 的模型库中拉取 Qwen 2.5 模型,并准备运行环境。

模型库

Ollama 支持 ollama.com/library 上提供的一系列模型

以下是一些可以下载的示例模型:

| 模型 | 参数 | 大小 | 下载 |

|---|---|---|---|

| DeepSeek-V2 | 16b | 8.9GB | ollama run deepseek-v2:16b |

| GLM-4 | 9 B | 5.5GB | ollama run glm4 |

| Llama 3.1 | 8B | 4.7GB | ollama run llama3.1 |

| Llama 3.1 | 70B | 40GB | ollama run llama3.1:70b |

| Llama 3.1 | 405B | 231GB | ollama run llama3.1:405b |

| Phi 3 Mini | 3.8B | 2.3GB | ollama run phi3 |

| Phi 3 Medium | 14B | 7.9GB | ollama run phi3:medium |

| Google Gemma 2 | 9B | 5.5GB | ollama run gemma2 |

| Google Gemma 2 | 27B | 16GB | ollama run gemma2:27b |

| Mistral | 7B | 4.1GB | ollama run mistral |

| Moondream 2 | 1.4B | 829MB | ollama run moondream |

| Neural Chat | 7B | 4.1GB | ollama run neural-chat |

| Starling | 7B | 4.1GB | ollama run starling-lm |

| Code Llama | 7B | 3.8GB | ollama run codellama |

| Llama 2 Uncensored | 7B | 3.8GB | ollama run llama2-uncensored |

| LLaVA | 7B | 4.5GB | ollama run llava |

| Solar | 10.7B | 6.1GB | ollama run solar |

| Qwen 2.5 | 0.5B | 398MB | ollama run qwen2:0.5b |

| Qwen 2.5 | 1.5B | 968MB | ollama run qwen2:1.5b |

| Qwen 2.5 | 3B | 1.9GB | ollama run qwen2:3b |

| Qwen 2.5 | 7B | 4.7GB | ollama run qwen2:7b |

| Qwen 2.5 | 14B | 9.0GB | ollama run qwen2:14b |

| Qwen 2.5 | 32B | 20GB | ollama run qwen2:32b |

| Qwen 2.5 | 72B | 47GB | ollama run qwen2:72b |

注意:您应至少拥有 8 GB 的 RAM 来运行 7B 型号,16 GB 的 RAM 来运行 14B 型号,32 GB 的 RAM 来运行 32B 型号。

交互示例

一旦模型运行起来,你可以通过命令行界面与之进行交互。试着输入一些问题或指令,看看模型如何回应。

结语

通过上述步骤,你可以快速开始使用 Ollama 并探索其功能。随着实践的深入,你将能够更充分地利用 Ollama 提供的各种模型来支持你的项目和研究。如果你在使用过程中遇到任何问题,不要忘记查阅官方文档或寻求社区的帮助。

作者:Jeebiz 创建时间:2024-04-24 09:06

最后编辑:Jeebiz 更新时间:2025-12-13 10:17

最后编辑:Jeebiz 更新时间:2025-12-13 10:17