基于 Llama3-12B-Chinese 定制 Ollama 本地模型

第一步: 下载 Llama3-12B-Chinese 模型文件

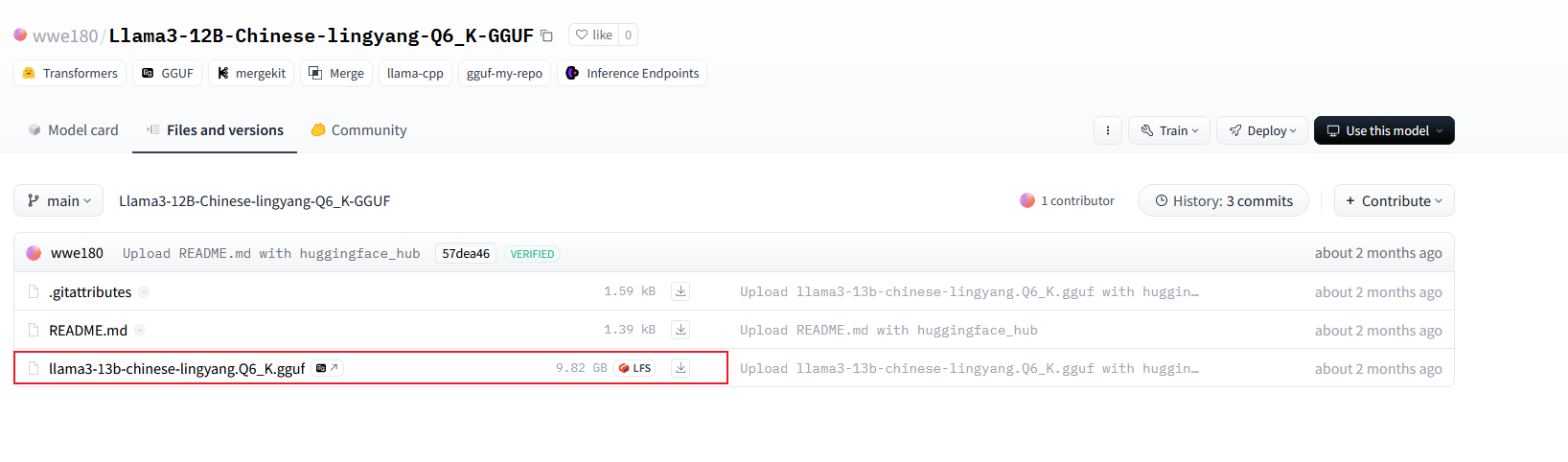

下面是 Hugging Face 官网地址,如果不能正常无法访问,需要科学上网,推荐国内镜像进行下载:

官网地址:https://huggingface.co/wwe180/Llama3-12B-Chinese-lingyang-Q6_K-GGUF/tree/main

国内镜像:https://hf-mirror.com/wwe180/Llama3-12B-Chinese-lingyang-Q6_K-GGUF/tree/main

第二步: 基于 GGUF 模型文件创建 Ollama 模型

1、在存放 Llama3-12B-Chinese 的 GGUF 模型文件目录中,创建一个文件名为 Modelfile 的文件,该文件的内容如下:

FROM ./llama3-13b-chinese-lingyang.Q6_K.gguf

TEMPLATE """

{{ if .System }}<|start_header_id|>system<|end_header_id|>

{{ .System }}<|eot_id|>{{ end }}{{ if .Prompt }}<|start_header_id|>user<|end_header_id|>

{{ .Prompt }}<|eot_id|>{{ end }}<|start_header_id|>assistant<|end_header_id|>

{{ .Response }}<|eot_id|>

"""

PARAMETER stop "<|start_header_id|>"

PARAMETER stop "<|end_header_id|>"

PARAMETER stop "<|eot_id|>"2、执行 ollama create llama3-13b-chinese:12b -f Modelfile ,在Ollama中创建模型

(base) PS C:\Users\Administrator> cd E:\LLMs\Llama3-12B-Chinese-lingyang

(base) PS E:\LLMs\Llama3-12B-Chinese-lingyang> ollama create llama3-13b-chinese:12b -f Modelfile

transferring model data

using existing layer sha256:fab43843b77fc4790a0561f9e2ca42891851017591eb12aef1d67286efe5a107

creating new layer sha256:549c786ef375489a2379ecfe1d244fde24c5ab78b9398a9343375556fffc6a14

creating new layer sha256:56bb8bd477a519ffa694fc449c2413c6f0e1d3b1c88fa7e3c9d88d3ae49d4dcb

creating new layer sha256:34eae7191823e979aacd63cca277cae7526ddd5aff13f0c8ae63cf6b8cd6302c

writing manifest

success3、执行ollama list验证是否创建成功

(base) PS E:\LLMs\Llama3-12B-Chinese-lingyang> ollama list

NAME ID SIZE MODIFIED

llama3-13b-chinese:12b fe35faf2d9d4 9.8 GB 58 seconds ago

gemma2:latest c19987e1e6e2 5.4 GB 2 days ago

mistral:latest 2ae6f6dd7a3d 4.1 GB 8 days ago从结果中可以看到我们刚创建的 llama3-13b-chinese:12b 模型,说明创建成功。

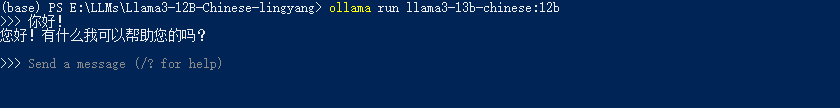

第三步:与创建的模型对话

ollama run llama3-13b-chinese:12b

可以尽情的对话了,下面我尝试下用 代码连接该模型!

作者:Jeebiz 创建时间:2024-07-05 21:35

最后编辑:Jeebiz 更新时间:2025-12-13 10:17

最后编辑:Jeebiz 更新时间:2025-12-13 10:17