Z-Image

Z-Image 是一款强大且高效的图像生成模型,拥有 60 亿参数。目前共有三个变体:

Z-Image-Turbo——Z-Image 的精简版本,仅需 8 次函数评估(NFEs)即可媲美乃至超越主流竞品。在企业级 H800 GPU 上实现亚秒级推理延迟,并轻松适配 16G 显存的消费级设备。其卓越性能体现在:逼真的图像生成、中英双语文本渲染,以及强大的指令遵循能力。

Z-Image-Base——未经蒸馏处理的基础模型。我们发布此检查点,旨在充分释放社区驱动的微调与定制开发的潜力。

Z-Image-Edit —— 一款基于 Z-Image 专项优化的图像编辑微调模型。该模型支持富有创意的图生图生成,具备卓越的指令跟随能力,可依据自然语言提示实现精准的图像编辑。

📣 News

[2025 年 12 月 08 日] Z-Image-Turbo 在 Artificial Analysis 文生图排行榜上位列总榜第 8 名,成为🥇开源模型第一名!查看完整排行榜。

[2025 年 12 月 1 日] Z-Image 技术报告已发布于arXiv平台。

[2025-11-26] Z-Image-Turbo 震撼发布!我们已在Hugging Face和ModelScope平台发布模型检查点。欢迎体验我们的在线演示!

📥 Model Zoo

| 模型 | Hugging Face | ModelScope |

|---|---|---|

| Z-Image-Turbo |   |

|

| Z-Image-Base | To be released | To be released |

| Z-Image-Edit | To be released | To be released |

🖼️ Showcase

逼真画质:Z-Image-Turbo 在保持卓越美学品质的同时,提供强大的照片级真实感图像生成能力。

精准双语文本呈现:Z-Image-Turbo 擅长准确呈现复杂的中英文文本。

提示增强与推理:提示增强器赋予模型推理能力,使其能够超越表层描述,深入挖掘潜在的世界知识。

🧠 创意图像编辑:Z-Image-Edit 展现出对双语编辑指令的深刻理解,能够实现富有想象力且灵活多变的图像转换。

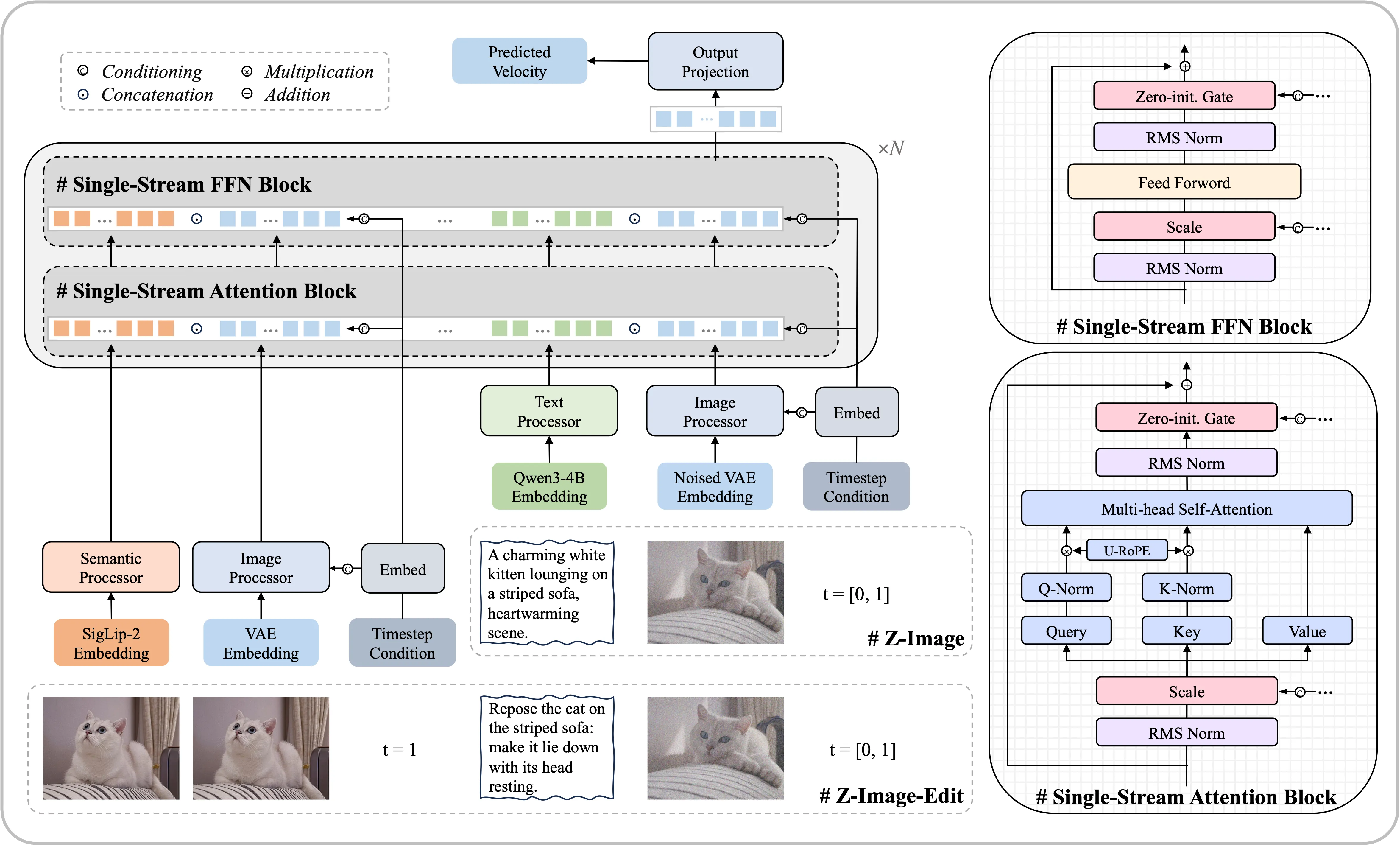

🏗️ 模型架构

我们采用了一种可扩展的单流 DiT(S3-DiT)架构。在此配置中,文本、视觉语义标记和图像 VAE 标记在序列级别进行拼接,作为统一的输入流,相较于双流方法,这种设计最大限度地提升了参数效率。

📈 Performance

Z-Image-Turbo 的性能已在多个独立基准测试中得到验证,其始终展现出业界顶尖水平的表现,尤其作为领先的开源模型更是如此。

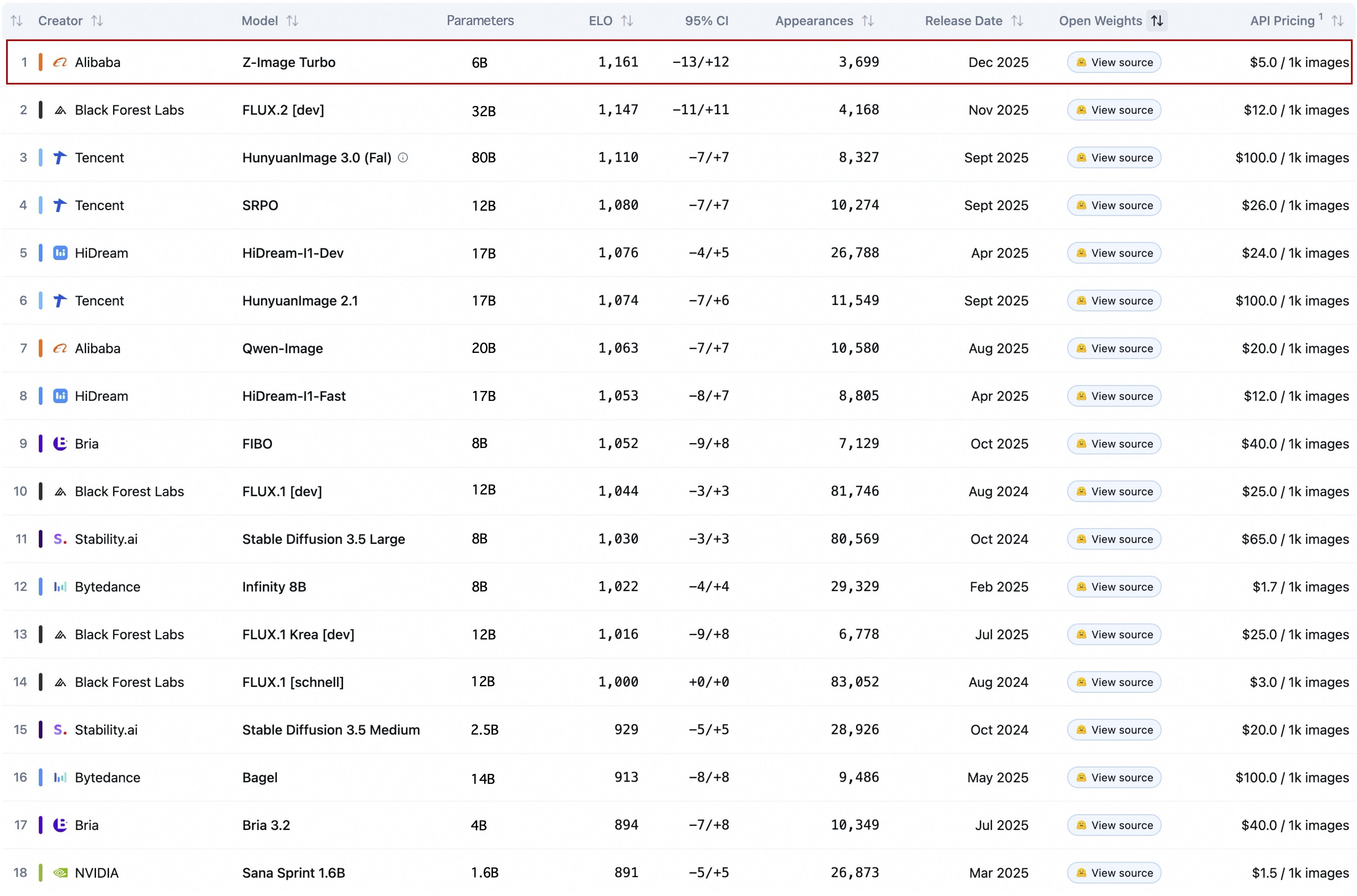

人工智能分析文本转图像排行榜

在竞争激烈的人工智能分析排行榜上,Z-Image-Turbo 综合排名第 8 位,并作为🥇#1 开源模型夺得榜首,表现优于所有其他开源替代方案。

人工智能分析排行榜

人工智能分析排行榜(仅限开源模型)

阿里巴巴 AI 竞技场文本生成图像排行榜

根据阿里巴巴 AI 竞技场基于 Elo 评分的人类偏好评估显示,Z-Image-Turbo 在开源模型中同样取得了业界领先的成绩,并与主流专有模型展现出极具竞争力的性能表现。

阿里巴巴 AI 竞技场文本生成图像排行榜

🚀 Quick Start

(1) PyTorch 原生推理

创建一个你喜欢的虚拟环境,然后安装依赖项:

pip install -e .然后运行以下代码以生成图像:

python inference.py(2) 扩散器推理

安装最新版本的 diffusers,请使用以下命令:

点击此处查看为何需要从源代码安装 diffusers 的详细信息

pip install git+https://github.com/huggingface/diffusers然后,尝试以下代码生成图像:

import torch

from diffusers import ZImagePipeline

# 1. Load the pipeline

# Use bfloat16 for optimal performance on supported GPUs

pipe = ZImagePipeline.from_pretrained(

"Tongyi-MAI/Z-Image-Turbo",

torch_dtype=torch.bfloat16,

low_cpu_mem_usage=False,

)

pipe.to("cuda")

# [Optional] Attention Backend

# Diffusers uses SDPA by default. Switch to Flash Attention for better efficiency if supported:

# pipe.transformer.set_attention_backend("flash") # Enable Flash-Attention-2

# pipe.transformer.set_attention_backend("_flash_3") # Enable Flash-Attention-3

# [Optional] Model Compilation

# Compiling the DiT model accelerates inference, but the first run will take longer to compile.

# pipe.transformer.compile()

# [Optional] CPU Offloading

# Enable CPU offloading for memory-constrained devices.

# pipe.enable_model_cpu_offload()

prompt = "Young Chinese woman in red Hanfu, intricate embroidery. Impeccable makeup, red floral forehead pattern. Elaborate high bun, golden phoenix headdress, red flowers, beads. Holds round folding fan with lady, trees, bird. Neon lightning-bolt lamp (⚡️), bright yellow glow, above extended left palm. Soft-lit outdoor night background, silhouetted tiered pagoda (西安大雁塔), blurred colorful distant lights."

# 2. Generate Image

image = pipe(

prompt=prompt,

height=1024,

width=1024,

num_inference_steps=9, # This actually results in 8 DiT forwards

guidance_scale=0.0, # Guidance should be 0 for the Turbo models

generator=torch.Generator("cuda").manual_seed(42),

).images[0]

image.save("example.png")解耦动态模态分解:Z-Image 背后的加速魔法

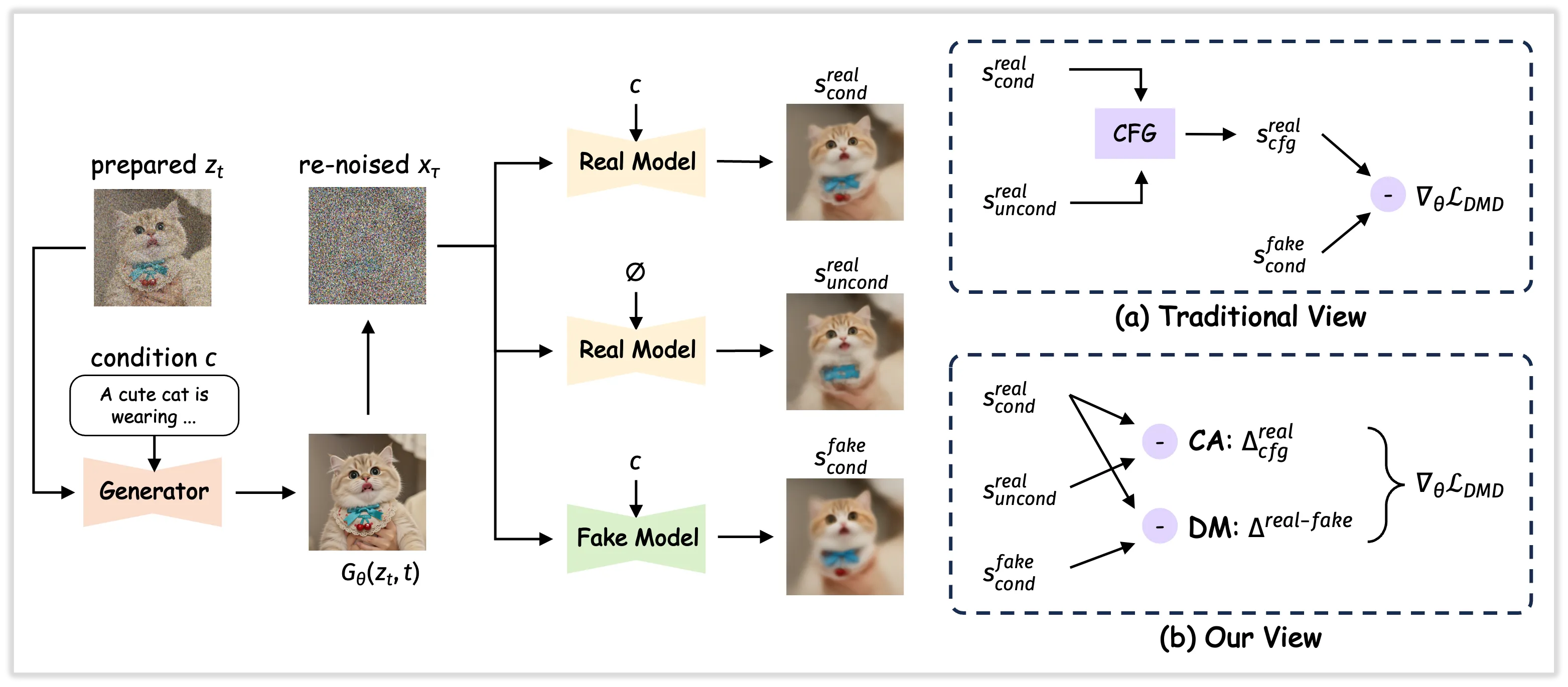

解耦动态模态分解(Decoupled-DMD)是支撑 8 步 Z-Image 模型的核心少步蒸馏算法。

我们在解耦 DMD(Decoupled-DMD)中的核心见解是,现有 DMD(分布匹配蒸馏)方法的成功源于两个独立且协同作用的机制:

- CFG 增强(CA):推动蒸馏过程的主要引擎,这一因素在以往的研究中大多被忽视。

- 分布匹配(DM):更多地充当一种正则化器️,确保生成输出的稳定性和质量。

通过识别并解耦这两种机制,我们得以独立研究和优化它们。这一认识最终促使我们开发出一种改进的蒸馏工艺,显著提升了少步生成任务的性能表现。

🤖 DMDR:融合动态模态分解与强化学习

基于 Decoupled-DMD 的坚实基础,我们的 8 步 Z-Image 模型已展现出卓越性能。为了在语义对齐、美学品质及结构连贯性方面实现进一步提升,同时生成富含高频细节的图像,我们正式推出 DMDR 方案。

DMDR 背后的核心洞见在于,在少步模型的后期训练阶段,强化学习(RL)与分布匹配蒸馏(DMD)能够实现协同整合。我们通过实验证明:

- RL 解锁 DMD 性能潜力

- DMD 有效规范化强化学习 ️

最后编辑:Ddd4j 更新时间:2026-02-27 09:37