Ollama × 魔搭社区:超简单的大模型本地部署方案

随着大模型的不断发展,小参数模型的能力也在逐渐进步,就拿阿里最新开源的qwen3来说,其中有负责多模态的qwen3-vl系列和专为代码优化的qwen3-code系列等,这些不同使用场景中都有开源的小参数模型来方便我们本地部署。

那开源部署小模型的好处有什么呢?小天认为至少有以下优势:

- 数据私有化:数据不出网,适合政企、学习或医院等对隐私要求高的场景。

- 无网络依赖:离线即可使用,不依赖网络。

- 成本大幅下降:本地推理成本降到最低(电费),比调用大模型api要省钱太多了。

- 微调门槛低:小模型比起大模型所需的庞大的资源来说更适合微调,小模型微调之后在特定领域的能力可以媲美甚至超过大模型。(微调可以理解为:用单独领域的数据集对模型再次训练使其专业化)

在应用落地方面,比如一些agent应用的落地,更离不开本地模型的部署,那说了这么多,如何正确的本地部署一个大模型呢?小天这里只推荐两种方法,这两种方法也是当下比较正确和常用的

- 通过Ollama工具快捷部署

- 通过vLLM高性能推理框架部署

本篇文章先讲通过ollama部署本地模型的方法。

那在本地部署之前,我们应该先明白当前的电脑配置能够运行什么参数的模型,不然我们辛辛苦苦下载了几十G的模型文件后,发现根本跑不动就尴尬了。

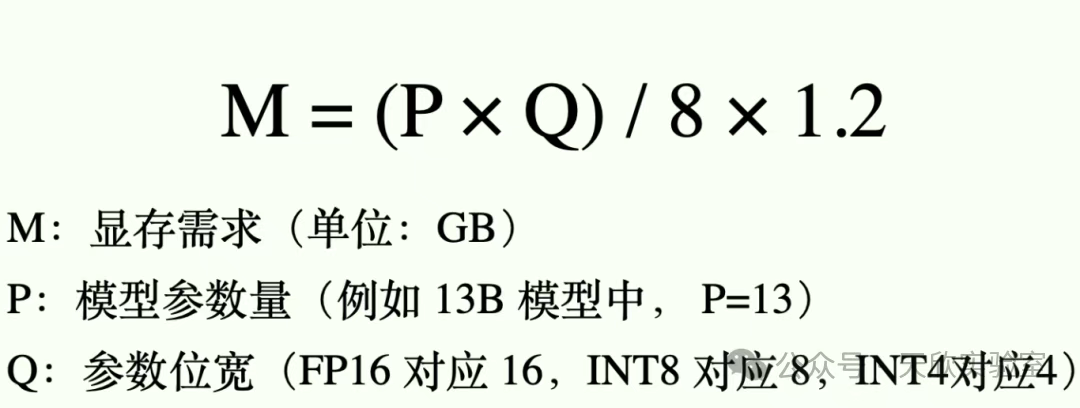

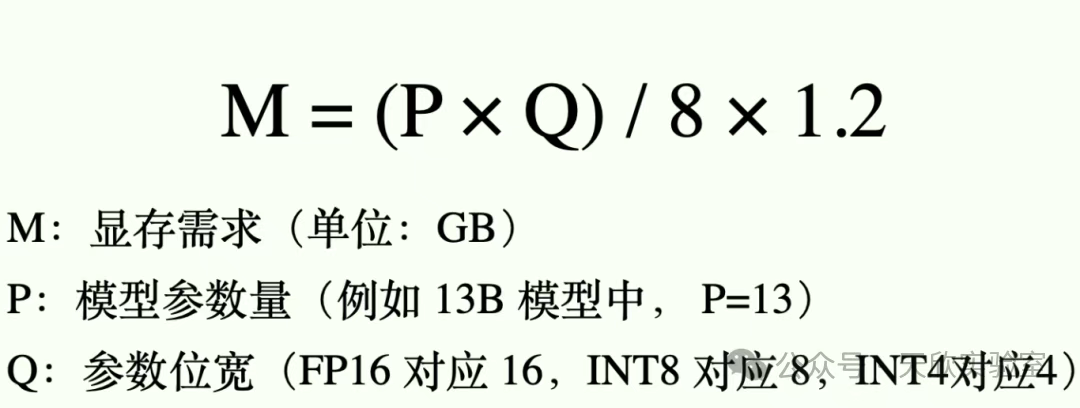

这里小天给大家一个可以快速估算的公式(最好自己电脑显存比这个结果多一些),如下图:

比如下面这个模型,部署它大概需要的显存的计算逻辑为:(8x8)/ 8x1.2=9.6G,也就是3060 12G显卡就可以跑,而且这个多模态的小模型能力也是相当不错。

这里涉及到两个概念:1.模型参数量 2.参数位宽。这俩个概念对于本地部署模型来说极其的重要,所以我觉得有必要说一下。

说之前大家要先了解一下魔搭社区,魔搭社区是阿里云的一个开源模型市场,里面有各种可下载的预训练好的模型以及数据集等,就像是中国版的Hugging Face。

链接:https://www.modelscope.cn/home

我们可以打开国内的模型市场——魔搭社区,然后搜索qwen3。

可以看到这些都有一个xxB的相关字样,比如30B、8B、235B这些字样,这些就是指得参数量,参数量越大就代表其掌握的知识越多,同时需要的显存越大!就比如图片上那个235B的模型需要的显存是500多G。这么大的显存,部署成本是相当大的。

我们点进去一个通义千问3-32B的模型中,在右侧部分可以看到这个模型的系谱,其中可以找到量化这一个分类。

点击这个分类,可以看到当前模型的量化版本,所谓量化其实就是指的是让模型尽量不变笨的情况下,节省部署显存。比如刚刚说的235B的模型经过4bit量化后,需要的显存就从500G降为了150G左右。

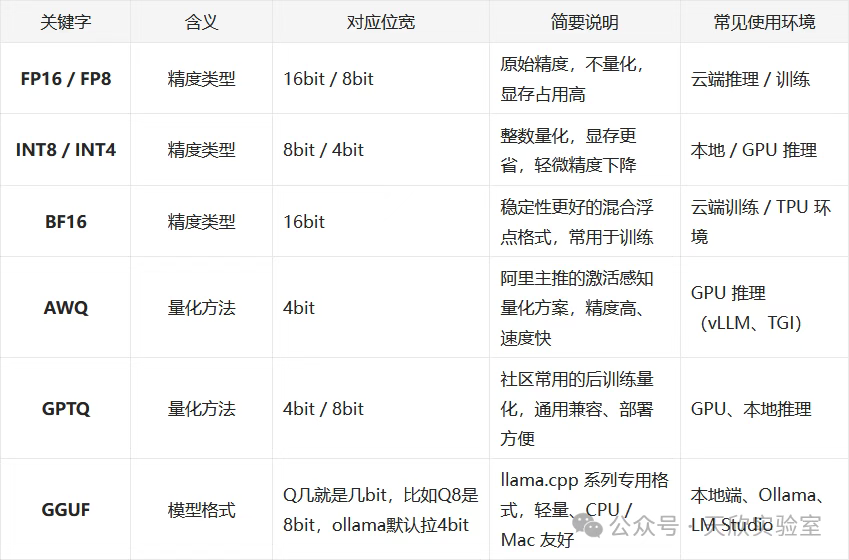

通过上图圈起来的部分,可以看到32B参数的qwen3文本对话模型的名称中包含,AWQ、FP8、GGUF、GPTQ,这些模型标识,对应的含义大家可以看下面这幅图:

其中AWQ是阿里最推荐的量化方法,你可以看到AWQ量化后的模型下载量一般都是最多的,而GGUF的模型格式则是我们接下来要讲的ollama主要支持的模型格式。这里要注意ollama主要支持的是gguf格式,而vllm可以支持绝大多数的模型格式,所以企业应用中大都是使用vllm部署模型而ollama多用于个人应用。

下面这些参数就代表了模型 的位宽,比如FP8就是8bit的,GPTQ-Int4就是4bit的,同理GPTQ-Int8也是8bit的,INT4就是4bit的。默认的AWQ和GGUF方法则是4bit的位宽。

可能第一时间有点不好理解所以小天给大家总结一下,显存资源有限情况下,一般vLLM框架来说使用AWQ量化后即可,但如果你要使用ollama就用GGUF格式的。

最后编辑:Ddd4j 更新时间:2026-02-27 09:37