OmniParser:文本识别、关键信息提取和表格识别的统一框架

论文 OmniParser: A Unified Framework for Text Spotting, Key Information Extraction and Table Recognition 提出了一种名为 OmniParser 的统一框架,用于解决视觉情境文本解析(Visually-situated Text Parsing, VsTP)问题,涵盖了文本定位、关键信息抽取以及表格识别三大任务。随着对自动化文档理解需求的增长和大语言模型在处理基于文档的问题上的能力增强,VsTP 领域取得了显著进步。然而,由于目标的多样化和结构的异质性,以往的研究通常为每个任务设计特定的架构和目标函数,导致模式孤立和工作流程复杂。

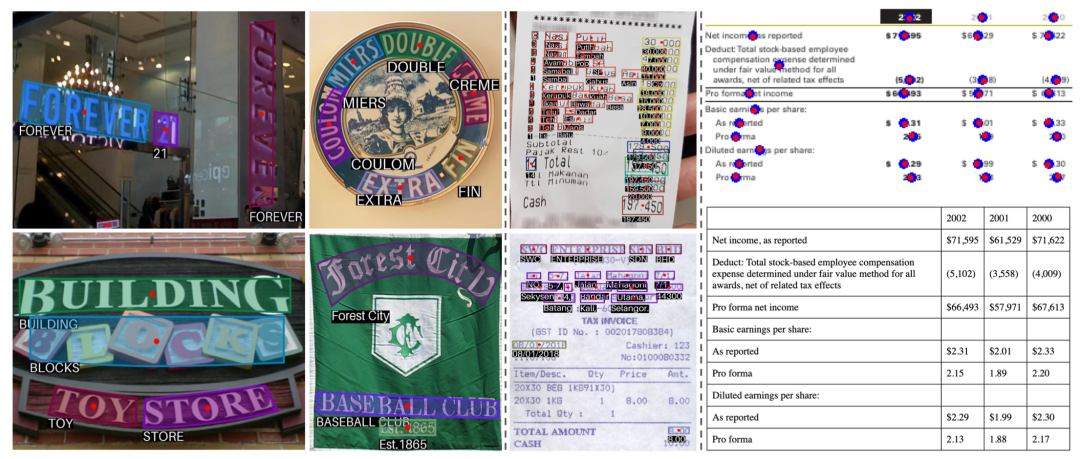

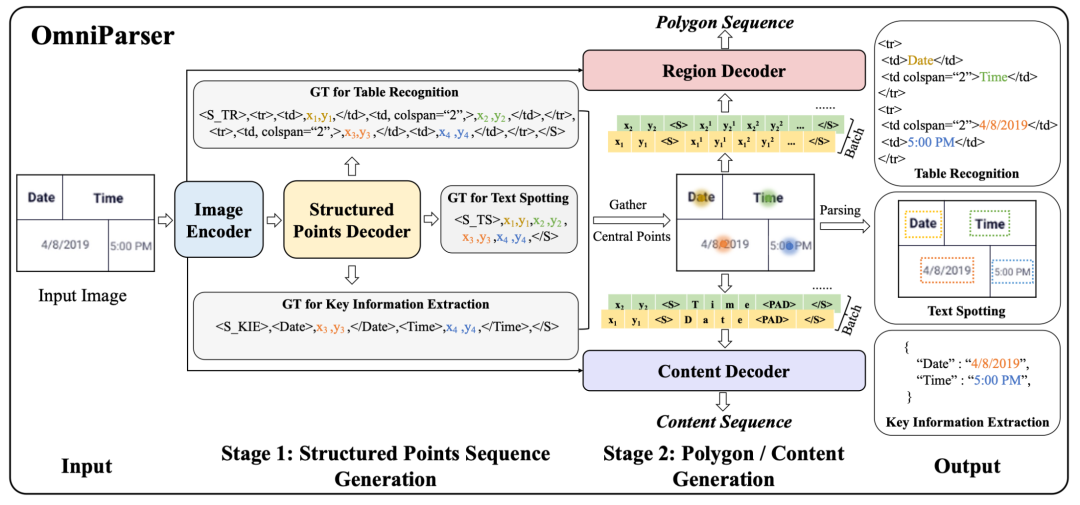

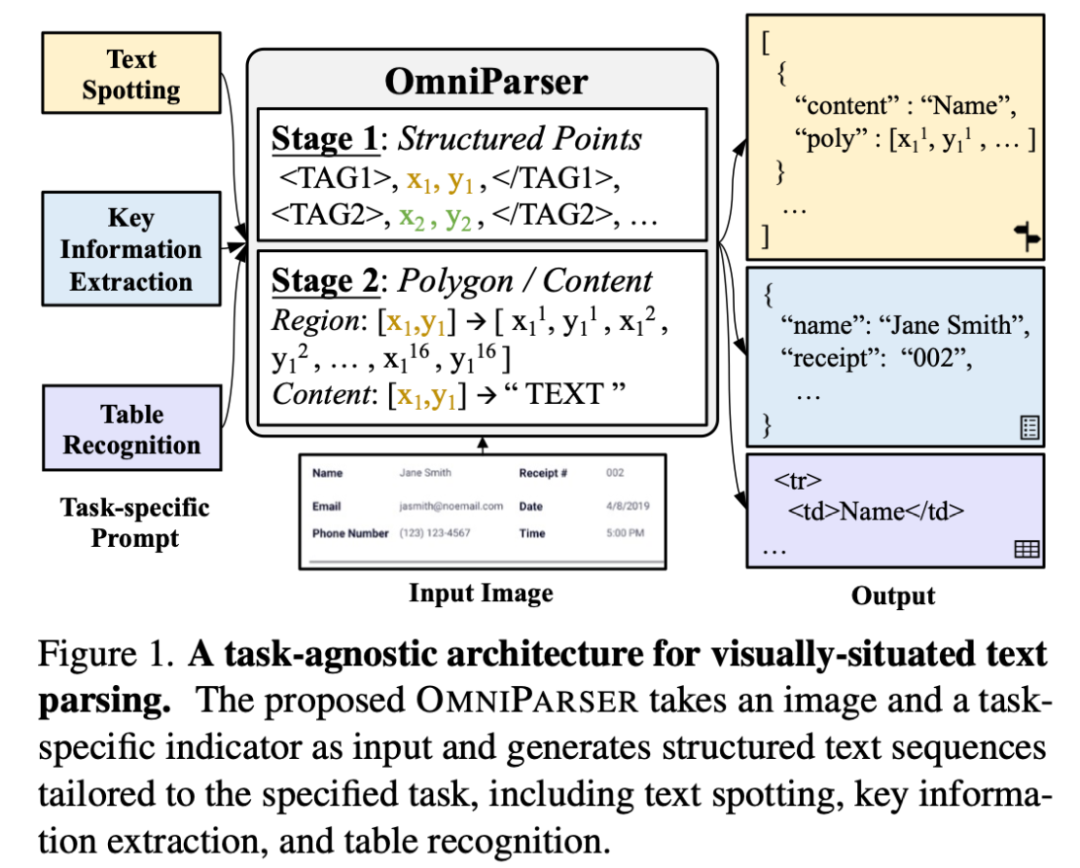

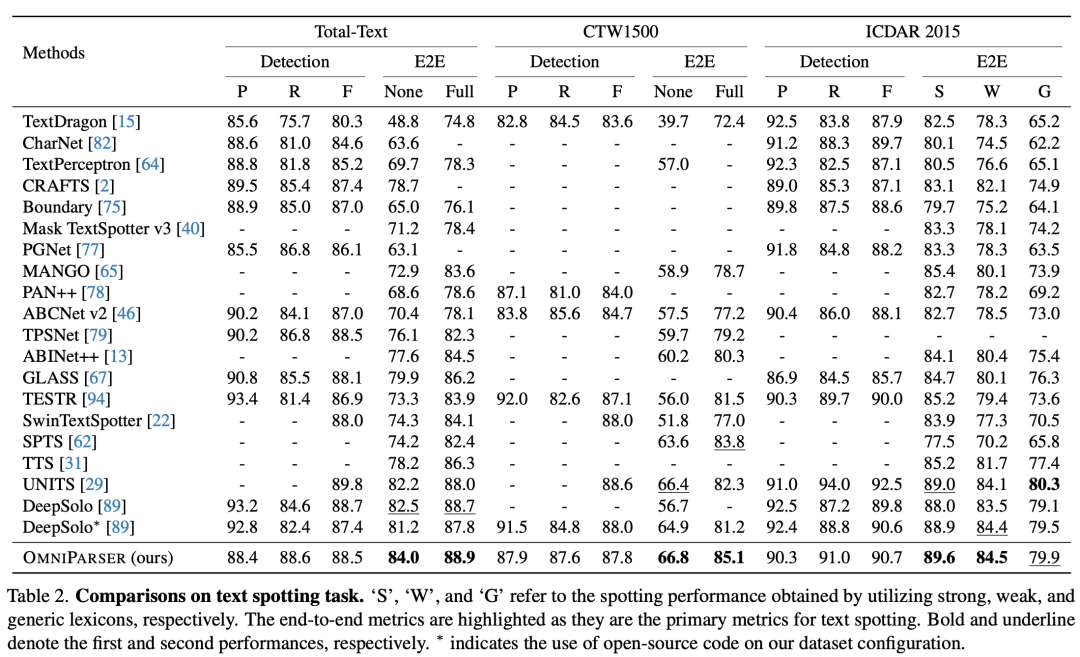

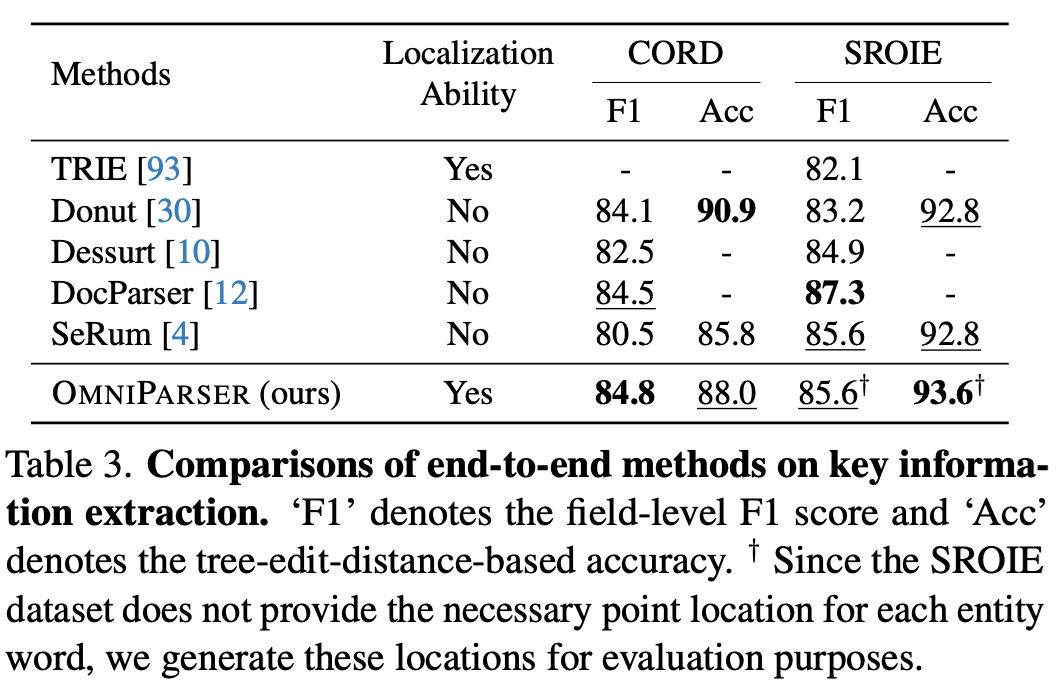

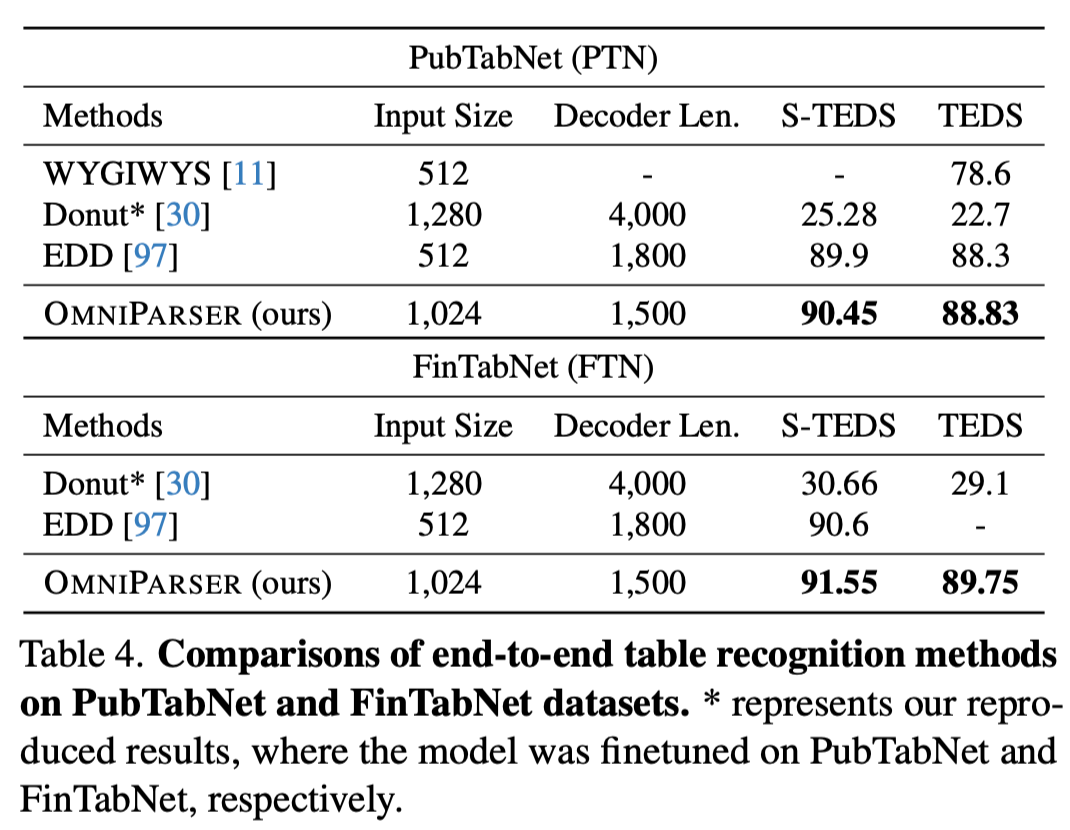

OmniParser 通过一种通用模型实现了跨多种场景下视觉情境文本的统一解析,该模型能够同时处理文本检测(Text Spotting)、关键信息提取(Key Information Extraction)及表格识别(Table Recognition)三个典型任务。在 OmniParser 中,所有任务共享一个统一的编码器-解码器架构、统一的目标函数(即点条件文本生成)和统一的输入输出表示方式(提示符&结构化序列)。广泛的实验结果表明,尽管采用了统一且简洁的设计,OmniParser 在针对这三个视觉情境文本解析任务的7个数据集上仍取得了 SOTA 或高度竞争性的性能。

OmniParser 引入了一个两阶段解码器,利用结构化点序列作为适配器,增强了对结构化信息的解析能力,并提供了更好的可解释性。设计了两种预训练策略,即空间感知提示和内容感知提示,使结构化点解码器能够学习视觉情境文本中的复杂结构和关系。

虽然 OmniParser 在视觉情境文本任务上表现出了巨大的潜力,但也存在一些局限性:首先,它依赖于训练阶段精确的词点位置信息,而在某些现实世界场景中可能无法获取;其次,不支持非文本元素如图表等的解析,限制了其在解决复杂文档解析任务上的能力。未来研究将着重于改进这些局限性,提升模型在实际应用中的鲁棒性和适用性。

参考资料

arXiv: https://arxiv.org/abs/2403.19128v1

GitHub: https://github.com/alibabaresearch/advancedliteratemachinery

最后编辑:Ddd4j 更新时间:2026-02-27 09:37