ReasonFlux:通过分层模板缩放提升 LLM 推理

大型语言模型(LLMs)已经展现出了卓越的问题解决能力,然而,复杂的推理任务 —— 例如竞技级别的数学问题或复杂的代码生成 —— 仍然具有挑战性。这些任务需要精确地穿越庞大的解空间,并进行细致的逐步思考。现有的方法虽然在提高准确性方面有所改进,但往往面临着高计算成本、僵化的搜索策略以及难以跨不同问题进行泛化的难题。

在这篇论文中,研究人员介绍了一个新的框架,ReasonFlux,它通过重新构想 LLMs 如何使用分层、模板引导的策略来规划和执行推理步骤,从而解决了这些局限性。 最近用于增强大型语言模型推理的方法分为两大类:深思熟虑的搜索和奖励引导的方法。像思维树(ToT)这样的技术使 LLM 能够探索多个推理路径,而蒙特卡洛树搜索(MCTS)则将问题分解为步骤,这些步骤由过程奖励模型(PRM)引导。

尽管这些方法有效,但由于采样过多和手动搜索设计,它们的可扩展性较差。例如,MCTS 需要遍历成千上万的潜在步骤,这使得它在实际应用中计算成本过高。与此同时,像思维缓冲(BoT)这样的检索增强生成 RAG 方法利用存储的问题解决模板,但在适应性地整合多个模板方面存在困难,这限制了它们在复杂场景中的效用。

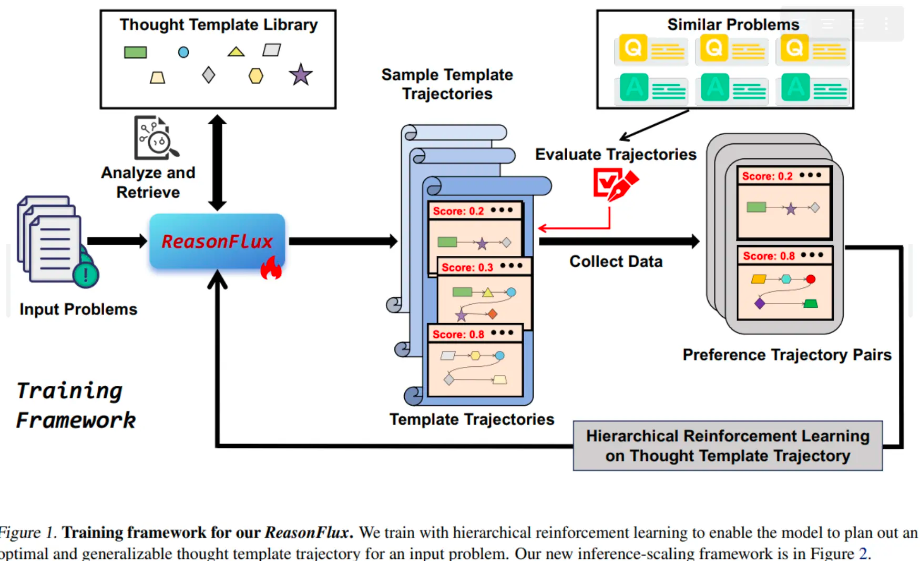

ReasonFlux 引入了一个结构化的框架,该框架结合了精选的高层次思维模板库与分层强化学习(HRL),以动态规划和优化推理路径。它不是优化单个步骤,而是专注于配置最优的 模板轨迹 —— 从结构化知识库中检索出的抽象问题解决策略序列。这种方法简化了搜索空间,并使高效适应子问题成为可能。该框架由三个主要组件组成:

结构化模板库:研究团队构建了一个包含 500 个思维模板的库,每个模板封装了一种问题解决策略(例如,“三角代换优化积分”)。模板包含元数据 —— 名称、标签、描述和应用步骤 —— 以实现高效的检索。例如,一个标记为 “有理函数优化” 的模板可能会指导大型语言模型(LLM)应用特定的代数替换。

分层强化学习:

基于结构的微调:将基本 LLM(例如,Qwen2.5-32B)微调以将模板元数据与其功能描述关联起来,确保它理解何时以及如何应用每个模板。

模板轨迹优化:利用偏好学习,该模型学会根据效果对模板序列进行排序。对于给定的问题,会采样多个轨迹,并根据它们在类似问题上的成功率来确定奖励。这训练模型优先考虑高奖励序列,从而提高其规划能力。

自适应推理缩放:在推理过程中,ReasonFlux 充当 “导航员”,分析问题以检索相关模板,并根据中间结果动态调整轨迹。例如,如果一个涉及 “多项式因式分解” 的步骤产生了意外的约束,系统可能会转向 “约束传播” 模板。这种规划和执行之间的迭代互动反映了人类的解决问题方式,其中部分解决方案会指导后续步骤。

ReasonFlux 在 MATH、AIME 和 OlympiadBench 等竞争级基准测试中进行了评估,超越了前沿模型(GPT-4o、Claude)以及专业开源模型(DeepSeek-V3、Mathstral)。关键结果包括:

- MATH 准确率达到 91.2%,超过 OpenAI 的 o1-preview 6.7%。

- AIME 2024 准确率为 56.7%,超出 DeepSeek-V3 45%,与 o1-mini 相当。

- OlympiadBench 准确率为 63.3%,比先前方法提高了 14%。此外,结构化模板库展示了强大的泛化能力:当应用于不同的问题时,它将小型模型(例如,7B 参数)的能力提升至能够通过直接推理超越大型模型。此外,ReasonFlux 实现了更好的探索 - 利用平衡,在复杂任务上比 MCTS 和 Best-of-N 需要少 40% 的计算步骤(见图 5)。 总结来说,ReasonFlux 重新定义了 LLMs 处理复杂推理的方式,通过将高级策略与逐步执行解耦。其分层模板系统减少了计算开销,同时提高了准确性和适应性,解决了现有方法中的关键差距。通过利用结构化知识和动态规划,该框架为高效、可扩展的推理设定了新的标准 —— 证明即使是小型、有良好指导的模型也能与最大的前沿系统相媲美。这一创新为在资源受限的环境中部署高级推理开辟了道路,从教育到自动化代码生成。

最后编辑:Ddd4j 更新时间:2026-02-27 09:37