Ollama 应用实践:如何选择合适的 Multimodal 模型 ?

在人工智能领域,多模态(Multimodal)指的是能够处理并理解来自多种不同类型数据源的信息的系统或模型。这些数据源通常包括但不限于文本、图像、音频和视频。多模态模型的核心优势在于它们能够同时分析和整合多种数据形式,从而提供更丰富、更全面的信息理解。

多模态模型的关键特点:

- 跨模态理解:模型能够理解不同模态之间的语义关联。

- 信息融合:模型能够将来自不同数据源的信息融合,以提供更准确的分析和响应。

- 上下文感知:模型在处理信息时能够考虑到上下文环境,以生成更合适的输出。

Ollama平台提供了多种多模态大模型,每种模型都针对不同的需求进行了优化。以下是选择合适Multimodal模型的一些关键因素:

- 确定需求:

- 明确您的项目是否需要模型同时理解图像和文本。

- 考虑模型是否需要支持特定的图像识别或文本分析任务。

- 模型性能:

- 查看模型在相关基准测试中的表现,选择性能出色的模型。

- 上下文理解能力:

- 如果项目需要处理大量图像和文本数据,选择支持长上下文的模型。

- 模型特性:

- 选择能够生成高质量输出的模型,并具备良好的理解和推理能力。

- 社区和文档:

- 选择有活跃社区支持和详尽文档的模型,以便快速解决问题。

通过考虑这些因素,您可以确保为您的项目选择最合适的多模态模型,从而提高开发效率、确保代码质量,并最终推动项目成功。

推荐的 Multimodal 模型

| 模型 | 参数大小 | 说明 |

|---|---|---|

| Janus Pro 7B | 7B |

适合需要高性能代码生成能力的场景 |

| CodeGeeX4 | 7B |

适合需要高性能代码生成能力的场景 |

| DeepSeek-Coder-V2 | 8B |

开源 MoE 代码语言模型,适合中英文双语编程任务 |

| CodeQwen 1.5 | 8B |

适合长上下文编程任务和多语言支持需求 |

| CodeGemma | 9B |

轻量级模型,专注于代码生成和自然语言理解 |

| Code Llama | 16B |

支持多种编程语言的代码生成和讨论 |

| StarCoder2 | 9B |

透明训练的开放代码 LLM,多种参数大小可选 |

| Replete-Coder-Qwen2 | 3.8B |

通用模型,专门训练于 100 多种编码语言 |

| SQLCoder-8B | 8B |

专注于 Postgres、Redshift 和 Snowflake 的文本到 SQL 生成。 |

- LLaVA:结合了视觉编码器和Vicuna,用于通用的视觉和语言理解,实现聊天功能。

- BakLLaVA:由Mistral 7B基础模型和LLaVA架构组成,适用于多模态任务。

- llava-llama3 和 llava-mistral:基于Mistral 7B模型微调,适用于研究大型多模式模型和聊天机器人。

- llava-phi3:基于Phi 3 Mini 4k微调,性能强大。

- MiniCPM-V:性能超越多个专有模型,支持超过30种语言的多模式对话。

- Nous-Hermes-2-Vision:集成了SigLIP-400M和自定义数据集富含函数调用,是视觉语言动作模型。

- Aura_v3_7B:改进版本,写作风格可控,适合多轮对话。

- j.o.s.i.e:具有多模式功能的下一代AI模型,由经验丰富的软件开发人员创建。

- smart-pig:基于llava-7b的模型,适用于特定的多模态任务。

更多支持 Vision 的模型详见:https://ollama.com/search?c=vision

DeepSeek-Janus-Pro-7B

Llama 3.2 Vision

Llama 3.2 Vision 是 11B 和 90B 大小的指令调整图像推理生成模型的集合。

文档地址:https://ollama.com/library/llama3.2-vision

Llama 3.2-Vision 多模态大型语言模型 (LLM) 集合是一组经过指令调整的图像推理生成模型,大小分别为 11B 和 90B(文本 + 图像输入/文本输出)。Llama 3.2-Vision 经过指令调整的模型针对视觉识别、图像推理、字幕和回答有关图像的一般问题进行了优化。这些模型在常见的行业基准上优于许多可用的开源和封闭多模态模型。

- 支持的语言:对于纯文本任务,官方支持英语、德语、法语、意大利语、葡萄牙语、印地语、西班牙语和泰语。Llama 3.2 已针对比这 8 种支持的语言更广泛的语言进行过训练。请注意,对于图像+文本应用程序,英语是唯一支持的语言。

LLaVA

LLaVA 是一种新颖的端到端训练的多模态大模型,它结合了

视觉编码器和Vicuna,用于通用的视觉和语言理解,实现了令人印象深刻的聊天功能。已更新至版本 1.6。

文档地址:https://ollama.com/library/llava

LLaVA 1.6 中的新功能:

- 将输入图像分辨率提高至多 4 倍像素,支持 672x672、336x1344、1344x336 分辨率。

- 通过改进的视觉指令调整数据混合,实现更好的视觉推理和 OCR 能力。

- 更好的视觉对话,适用于更多场景,涵盖不同的应用程序。

- 更好的世界知识和逻辑推理。

CLI 使用

运行模型:

然后在提示符下,在提示符中包含图像的路径:

API 使用

BakLLaVA

BakLLaVA 是一个多模态模型,由 Mistral 7B 基础模型和 LLaVA 架构组成。

文档地址:https://ollama.com/library/bakllava

CLI 使用

运行模型:

然后在提示符下,在提示符中包含图像的路径:

API 使用

llava-llama3

基于 Mistral 7B 模型微调的新 LLaVA 模型。

有可能的使用

- 主要预期用途:LLaVA 的主要用途是研究大型多模式模型和聊天机器人。

- 主要目标用户:该模型的主要目标用户是计算机视觉、自然语言处理、机器学习和人工智能领域的研究人员和业余爱好者。

训练数据集

- 来自 LAION/CC/SBU 的 558K 幅经过过滤的图像文本对,由 BLIP 提供标题。

- 158K GPT 生成的多模式指令跟踪数据。

- 500K 面向学术任务的 VQA 数据混合。

- 50K GPT-4V 数据混合。

- 40K ShareGPT 数据。

文档地址:https://ollama.com/mapler/llava-mistral

llava-mistral

基于 Mistral 7B 模型微调的新 LLaVA 模型。

有可能的使用

- 主要预期用途:LLaVA 的主要用途是研究大型多模式模型和聊天机器人。

- 主要目标用户:该模型的主要目标用户是计算机视觉、自然语言处理、机器学习和人工智能领域的研究人员和业余爱好者。

训练数据集

- 来自 LAION/CC/SBU 的 558K 幅经过过滤的图像文本对,由 BLIP 提供标题。

- 158K GPT 生成的多模式指令跟踪数据。

- 500K 面向学术任务的 VQA 数据混合。

- 50K GPT-4V 数据混合。

- 40K ShareGPT 数据。

文档地址:https://ollama.com/mapler/llava-mistral

llava-phi3

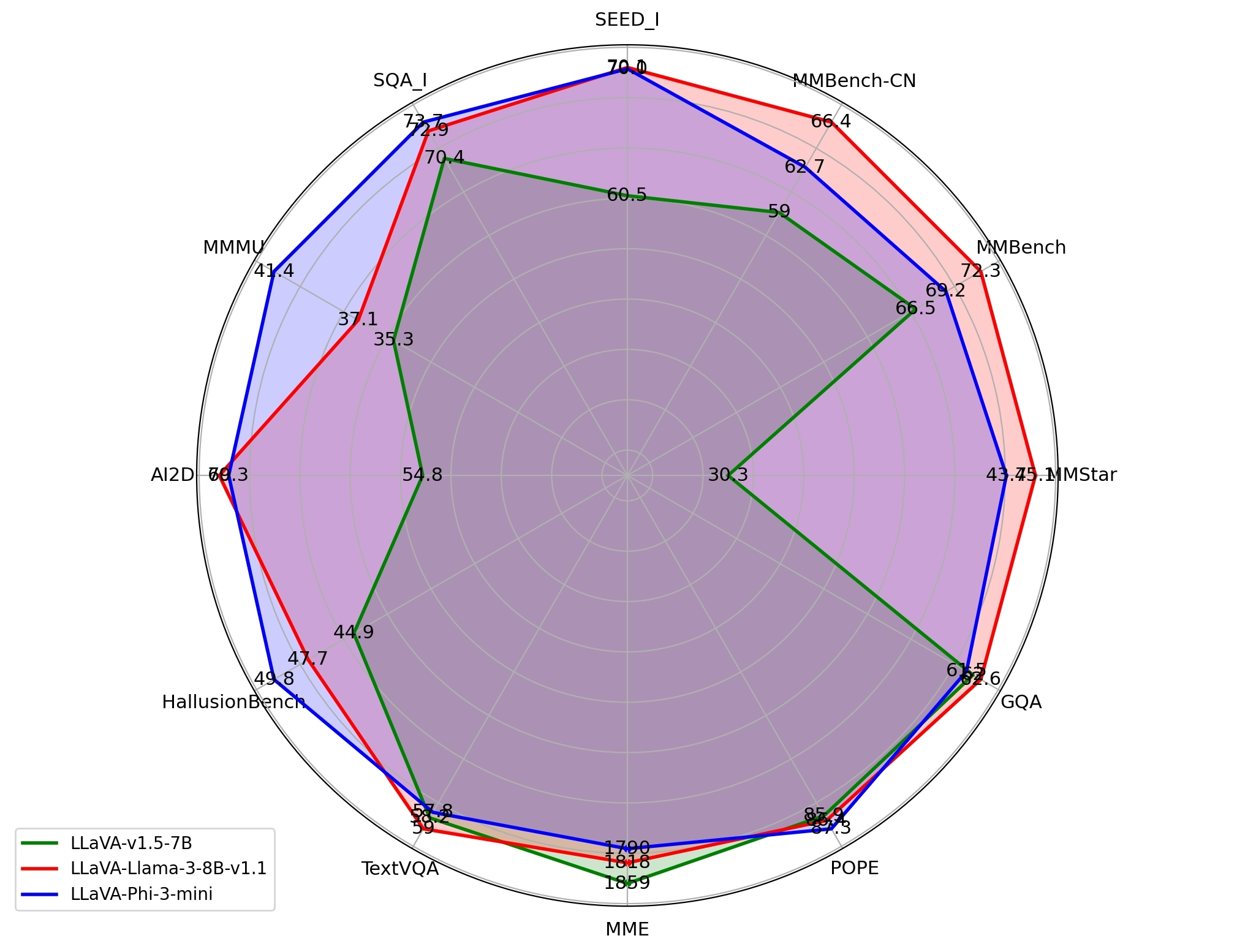

llava-phi3 是基于 Phi 3 Mini 4k 微调的 LLaVA 模型,其强大的性能基准与原始 LLaVA 模型相当:

文档地址:https://ollama.com/library/llava-phi3

MiniCPM-V

MiniCPM-V 的整体性能超越了 GPT-4V、Gemini Pro、Qwen-VL 和 Claude 3 等专有模型,并支持超过 30 种语言的多模式对话。

文档地址:https://ollama.com/hhao/openbmb-minicpm-llama3-v-2_5

在 Docker 中运行(使用cpu或者gpu)

- 支持 x86_64 和 arm64 操作系统

- 支持 CUDA (NVIDIA) 和 ROCm (AMD)

Nous-Hermes-2-Vision

Nous-Hermes-2-Vision 是开创性的视觉语言模型,利用了 teknium 著名的OpenHermes-2.5-Mistral-7B的进步。该模型包含两项关键增强功能,使其成为一种尖端解决方案:

SigLIP-400M 集成:与依赖大量 3B 视觉编码器的传统方法不同,Nous-Hermes-2-Vision 利用了强大的 SigLIP-400M。这一战略选择不仅简化了模型的架构,使其更轻量,而且还充分利用了 SigLIP 的卓越功能。结果如何?性能显著提升,超出了传统的预期。

自定义数据集富含函数调用:我们模型的训练数据包含一个独特的功能——函数调用。这一独特的附加功能将 Nous-Hermes-2-Vision 转变为视觉语言动作模型。开发人员现在可以使用多功能工具,用于制作大量巧妙的自动化功能。

文档地址:https://ollama.com/GFalcon-UA/nous-hermes-2-vision

Aura_v3_7B

Aura v3 是一个改进版本,其写作风格明显更加可控。默认情况下,它会偏爱诗意的散文,但如果得到指示,它可以采用更平易近人的风格。此版本具有情色、RP 数据和 NSFW 配对,可提供更顺从的心态。

我建议将温度保持在 1.5 左右或更低,最小 P 值为 0.05。在较高温度下,此模型可能会因散文而失去控制。不过我要说的是,此模型的散文与 GPT 3.5/4 变体不同,并为输出增添了人性化的气息。我知道这个模型过度拟合了,但这正是整个练习的重点。

如果您无法让模型遵循星号/引号格式,我建议您改用星号/纯文本。此模型倾向于较短的输出,因此如果您想要更长的输出,请准备好延长您的介绍和示例。

该模型最适合用于 ChatML 的多轮对话。

与所有其他基于 Mistral 的模型一样,该模型与 Mistral 兼容的 mmproj 文件兼容,以实现 KoboldCPP 中的多模式视觉功能。

文档地址:https://ollama.com/eramax/aura_v3

j.o.s.i.e

goekdenizguelmez 是一位经验丰富的软件开发人员,在人工智能领域拥有扎实的背景。他热衷于人工智能,并将他的技术技能与对该领域的热情相结合,创建了 J.O.S.I.E. 助手,这是一个具有多模式功能的下一代 AI 模型。

文档地址:https://ollama.com/goekdenizguelmez/j.o.s.i.e.v4o-7b-stage1-beta3.2

smart-pig

基于llava-7b的模型。

文档地址:https://ollama.com/bfhui/smart-pig

最后编辑:Jeebiz 更新时间:2025-02-17 14:19