Ollama 应用实践:如何选择合适的 Chat 模型 ?

选择合适的聊天模型(Chat model)对于确保对话系统的性能和适用性至关重要。Ollama 提供了多种 Chat 模型,每种模型都有其特点和最佳使用场景。以下是一些关键因素,可以帮助您在使用 Ollama 时做出选择:

1. 应用场景和需求识别

- 评估您的对话系统是否需要处理特定主题或行业术语。

- 确定是否需要多语言支持,以及这些语言的对话复杂性。

2. 模型规模与资源匹配

- 根据可用的计算资源,选择合适大小的模型,平衡性能和资源消耗。

- 考虑模型的上下文窗口大小,确保它能够处理预期的对话深度和长度。

3. 性能与优化

- 查看模型的性能评估和基准测试结果,了解其在类似应用场景中的表现。

- 选择针对对话任务优化过的模型,特别是那些经过特定场景微调的版本。

4. 法律与伦理合规性

- 确保所选模型的使用遵守数据保护法规和伦理准则。

- 考虑模型可能产生的偏见和误解,并选择那些注重公平性和透明度的模型。

5. 社区支持与文档完善度

- 选择有活跃社区支持的模型,这通常意味着更好的问题解决和资源共享。

- 确保模型有详尽的文档,包括安装指南、使用案例和API参考。

通过考虑这些因素,您可以确保选择的模型不仅满足当前的技术需求,而且也符合长期的业务和合规要求。记住,最合适的模型不一定是最大的模型,而是最符合您特定需求的模型。

推荐的 Chat 模型

Ollama Chat 模型是一个基于大型语言模型的对话系统,支持对话问答、文本生成等功能。

以下是一些推荐的 Ollama Chat 模型:

| 模型 | 参数大小 | |

|---|---|---|

| DeepSeek-R1 | 16B |

查看模型 |

| Qwen2.5 | 7B |

查看模型 |

| GLM-4 | 9B |

查看模型 |

| Llama 3.3 | 8B |

查看模型 |

| Mistral NeMo | 12B |

查看模型 |

| Mistral Large 2 | 123B |

查看模型 |

| Google Gemma 2 | 9B |

查看模型 |

| Google Gemma | 8B |

查看模型 |

| Phi-3 Mini | 3.8B |

查看模型 |

| Phi-3 Medium | 14B |

查看模型 |

DeepSeek-R1

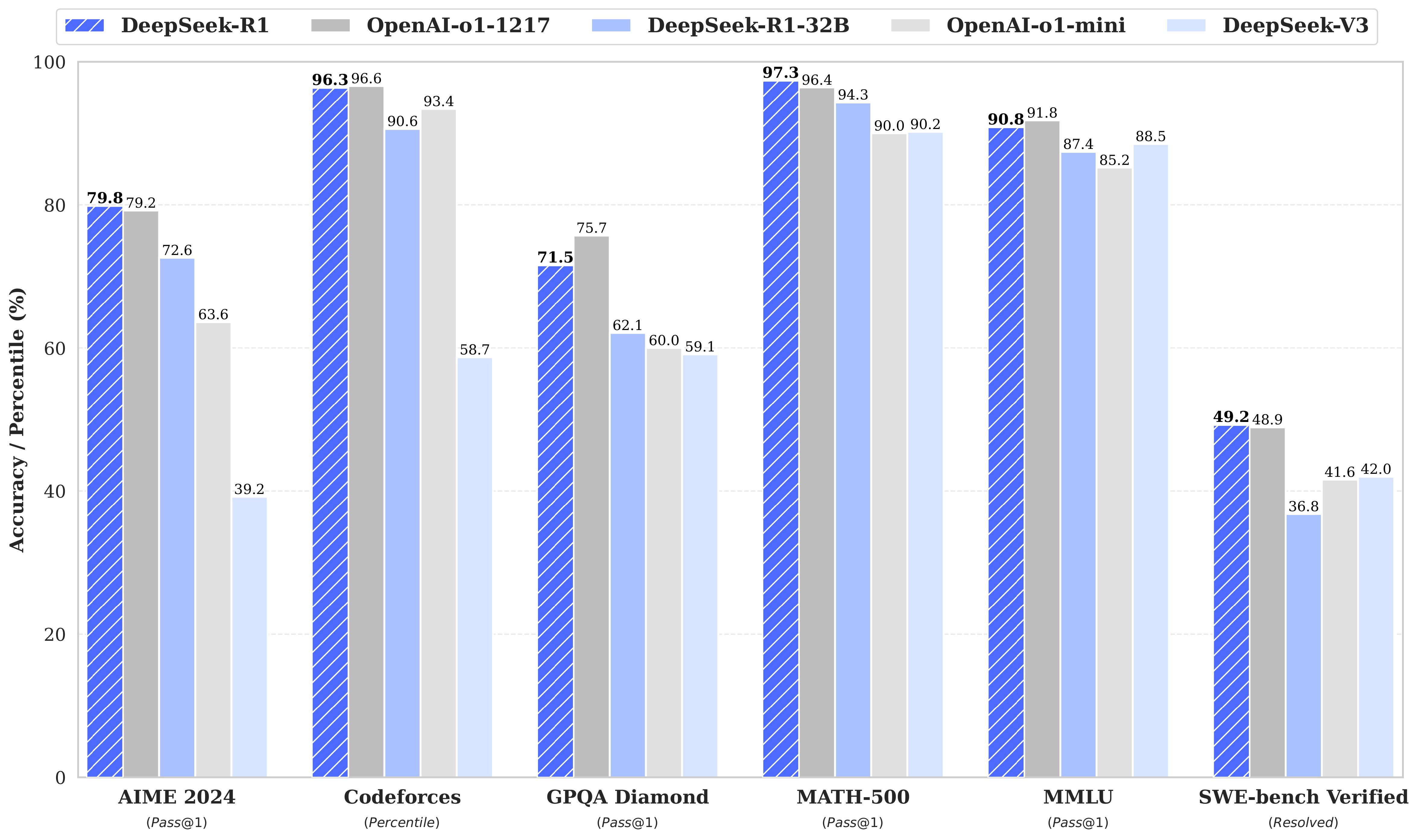

DeepSeek-R1 是一种强大的混合专家 (MoE) 语言模型,具有经济的训练和高效的推理特点。在数学、代码和推理任务中实现了与 OpenAI-o1 相当的性能。

模型

DeepSeek-R1 生成的推理数据,针对研究界广泛使用的几种密集模型进行微调而创建的模型。评估结果表明,提炼出的较小密集模型在基准测试中表现优异。

- DeepSeek-R1

- DeepSeek-R1-Distill-Qwen-1.5B

- DeepSeek-R1-Distill-Qwen-7B

- DeepSeek-R1-Distill-Llama-8B

- DeepSeek-R1-Distill-Qwen-14B

- DeepSeek-R1-Distill-Qwen-32B

- DeepSeek-R1-Distill-Llama-70B

Qwen2.5

Qwen2.5 模型在阿里巴巴最新的大规模数据集上进行了预训练,涵盖高达 18 万亿个 token。该模型最多支持 128K 个 token,并支持多语言。

- 模型地址:https://ollama.com/library/qwen2.5

- 文档地址:https://qwen.readthedocs.io/zh-cn/latest/run_locally/ollama.html

最新版本Qwen2.5有以下特点:

- 易于使用的仅解码器稠密语言模型,提供 0.5B 、1.5B 、3B 、7B 、14B 、32B 和 72B 共7种参数规模的模型,并且有基模型和指令微调模型两种变体(其中“ B ”表示“十亿”, 72B 即为 720 亿)

- 利用我们最新的数据集进行预训练,包含多达 18T tokens (其中“ T ”表示“万亿”, 18T 即为 18 万亿)

- 在遵循指令、生成长文本(超过 8K tokens )、理解结构化数据(例如,表格)以及生成结构化输出特别是 JSON 方面有了显著改进

- 更加适应多样化的系统提示,增强了角色扮演的实现和聊天机器人的背景设置。

- 支持最多达 128K tokens 的上下文长度,并能生成多达 8K tokens 的文本。

- 支持超过 29 种语言,包括中文、英文、法文、西班牙文、葡萄牙文、德文、意大利文、俄文、日文、韩文、越南文、泰文、阿拉伯文等。

您可以通过以下方式选择运行不同大小的Qwen2.5-Instruct模型:

GLM-4

GLM-4-9B 是智谱 AI 推出的最新一代预训练模型 GLM-4 系列中的开源版本。在语义、数学、推理、代码和知识等多方面的数据集测评中,GLM-4-9B 及其人类偏好对齐的版本 GLM-4-9B-Chat 均表现出超越 Llama-3-8B 的卓越性能。除了能进行多轮对话,GLM-4-9B-Chat 还具备网页浏览、代码执行、自定义工具调用(Function Call)和长文本推理(支持最大 128K 上下文)等高级功能。本代模型增加了多语言支持,支持包括日语,韩语,德语在内的 26 种语言。我们还推出了支持 1M 上下文长度(约 200 万中文字符)的 GLM-4-9B-Chat-1M 模型和基于 GLM-4-9B 的多模态模型 GLM-4V-9B。GLM-4V-9B 具备 1120 * 1120 高分辨率下的中英双语多轮对话能力,在中英文综合能力、感知推理、文字识别、图表理解等多方面多模态评测中,GLM-4V-9B 表现出超越 GPT-4-turbo-2024-04-09、Gemini1.0 Pro、Qwen-VL-Max 和 Claude 3 Opus 的卓越性能。

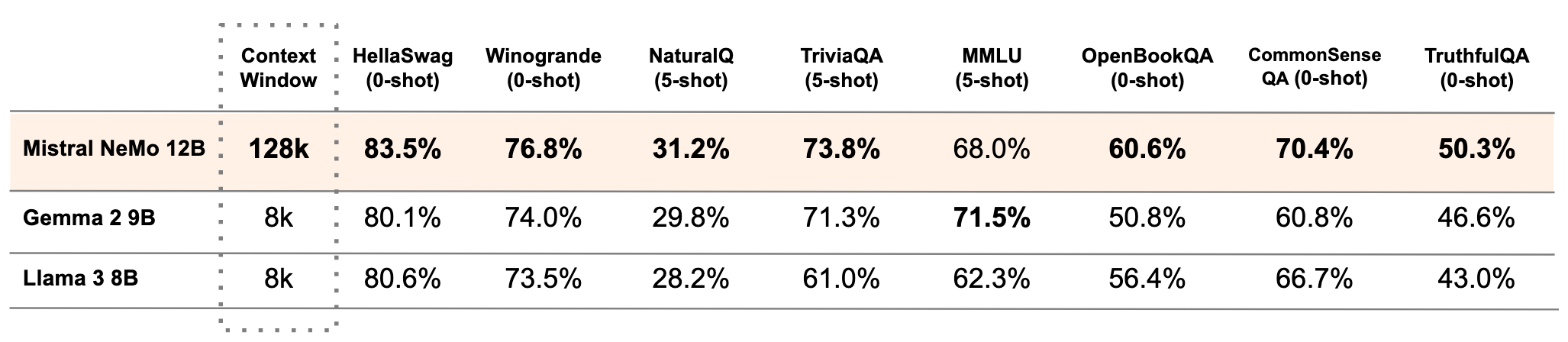

Mistral NeMo

Mistral NeMo 是由 Mistral AI 与 NVIDIA 合作构建的最先进的 12B 模型。Mistral NeMo 提供高达 128k 个 token 的大型上下文窗口。其推理、世界知识和编码准确性在同类规模中处于领先地位。由于它依赖于标准架构,Mistral NeMo 易于使用,并且是使用 Mistral 7B 的任何系统中的直接替代品。

Mistral Large 2

Mistral Large 2 是 Mistral 的新旗舰型号,其代码生成、数学和推理能力显著增强,具有 128k 上下文窗口并支持数十种语言。

Mistral-Large-Instruct-2407 是一种先进的密集大型语言模型 (LLM),具有 123B 参数和最先进的推理、知识和编码能力。

主要特征

多语言设计:支持数十种语言,包括英语、法语、德语、西班牙语、意大利语、中文、日语、韩语、葡萄牙语、荷兰语和波兰语。

精通编码:接受过 80 多种编码语言的培训,例如 Python、Java、C、C++、JavacScript 和 Bash。还接受过更具体的语言的培训,例如 Swift 和 Fortran。

以代理为中心:具有本机函数调用和 JSON 输出的最佳代理功能。

高级推理:最先进的数学和推理能力。

Mistral 研究许可证:允许出于研究和非商业用途的使用和修改。

大上下文:一个大的 128k 上下文窗口。

Google Gemma 2

Google 的 Gemma 2 型号有两种尺寸:9B 和 27B,采用全新的架构设计,可实现一流的性能和效率。

一流的性能

Gemma 2 拥有 270 亿个参数,其性能在基准测试中超越了比其规模大两倍的模型。这一突破性的效率为开放模型领域树立了新标准。

两种尺寸:9B 和 27B 参数

- 9B 参数:

ollama run gemma2 - 27B 参数:

ollama run gemma2:27b

Google Gemma

Gemma 是 Google 及其 DeepMind 团队开发的一种新开放模型。其灵感来自 Google 的 Gemini 模型。

Gemma 有两种2b尺寸7b:

ollama run gemma:2bollama run gemma:7b(默认)

文档地址:https://ollama.com/library/gemma

Phi-4

Phi-4 是一个微软开源的 14B 参数模型。

Phi-3

Phi-3 是微软推出的轻量级 3B(迷你)和 14B(中型)先进开放模型系列。

文档地址:https://ollama.com/library/phi3

参数大小

- Phi-3 Mini – 3B 参数 –

ollama run phi3:mini - Phi-3 Medium – 14B 参数 –

ollama run phi3:medium

Phi-3 Mini

Phi-3 Mini 是一个拥有 38 亿参数的轻量级、最先进的开放模型,使用 Phi-3 数据集进行训练,该数据集包含合成数据和经过过滤的公开网站数据,重点关注高质量和推理密集属性。

该模型经历了后期训练过程,结合了监督微调和直接偏好优化,以确保精确遵守指令和强有力的安全措施。

在根据常识、语言理解、数学、代码、长上下文和逻辑推理的基准测试进行评估时,Phi-3 Mini-4K-Instruct 在参数少于 130 亿的模型中展现出了强大且最先进的性能。

Phi-3 Medium

Phi-3 Medium 是一个 14B 参数语言模型,其性能优于 Gemini 1.0 Pro。

最后编辑:Jeebiz 更新时间:2025-02-17 14:18