一、介绍

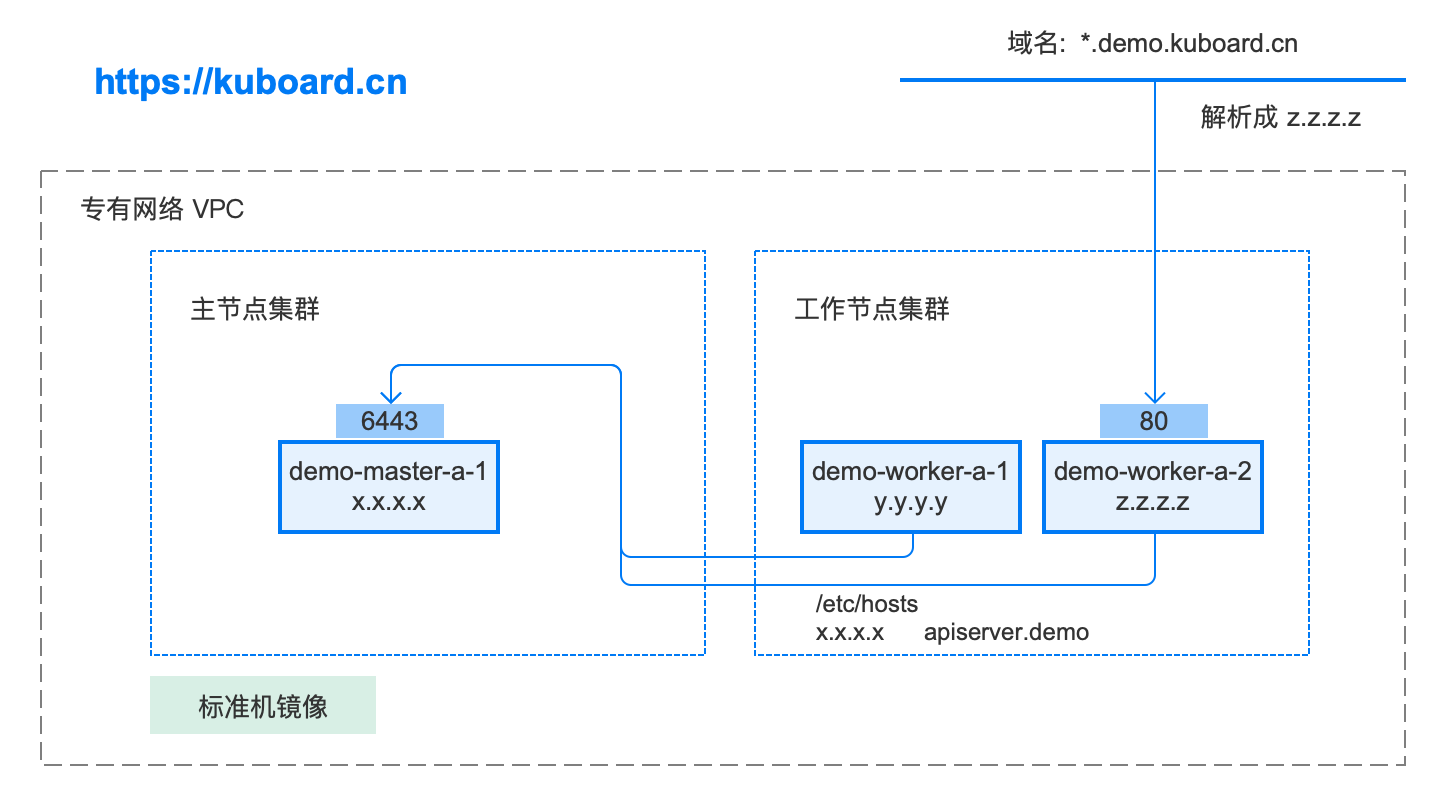

kubernetes 安装有多种选择,本文档描述的单节点集群安装具备如下特点:

- Kubernetes 1.15.2

- Docker 18.09.7

- 一个 master 组成主节点集群

- 两个 worker 组成工作节点集群

- 使用 calico 作为网络插件

- 使用 nginx-ingress 作为 kubernetes ingress controller

安装后的拓扑图如下:

一、安装准备

1、系统要求

1.1、K8s-Master

| 最低要求 | |

|---|---|

| CPU | 支持 64 位的 Intel® 或 AMD 处理器*;2 GHz 或速度更快的处理器 |

| 内存 | 16 GB 或更大 RAM(推荐使用 16 GB) |

| 硬盘 | 需要 500GB 以上的可用磁盘空间 |

| 操作系统 | CentOS 7.6 或更高版本 |

1.2、K8s-Worker1

| 最低要求 | |

|---|---|

| CPU | 支持 64 位的 Intel® 或 AMD 处理器*;2 GHz 或速度更快的处理器 |

| 内存 | 16 GB 或更大 RAM(推荐使用 16 GB) |

| 硬盘 | 需要 500GB 以上的可用磁盘空间 |

| 操作系统 | CentOS 7.6 或更高版本 |

1.3、K8s-Worker2

| 最低要求 | |

|---|---|

| CPU | 支持 64 位的 Intel® 或 AMD 处理器*;2 GHz 或速度更快的处理器 |

| 内存 | 16 GB 或更大 RAM(推荐使用 16 GB) |

| 硬盘 | 需要 500GB 以上的可用磁盘空间 |

| 操作系统 | CentOS 7.6 或更高版本 |

2、软件要求

- Kubernetes 1.15.2

- Docker 18.09.7

3、系统设置

3.1、设置镜像源

因为国外镜像网速较慢,推荐设置阿里云镜像源:https://opsx.alibaba.com/mirror

1.1、备份

[root@nexus ~]# mv /etc/yum.repos.d/CentOS-Base.repo /etc/yum.repos.d/CentOS-Base.repo.backup1.2、下载新的CentOS-Base.repo 到/etc/yum.repos.d/

[root@nexus ~]# wget -O /etc/yum.repos.d/CentOS-Base.repo http://mirrors.aliyun.com/repo/Centos-7.repo或者

[root@nexus ~]# curl -o /etc/yum.repos.d/CentOS-Base.repo http://mirrors.aliyun.com/repo/Centos-7.repo1.3、之后运行yum makecache生成缓存

[root@docker]# sudo yum makecache all;1.4、执行yum update 更新系统组件到最新版本

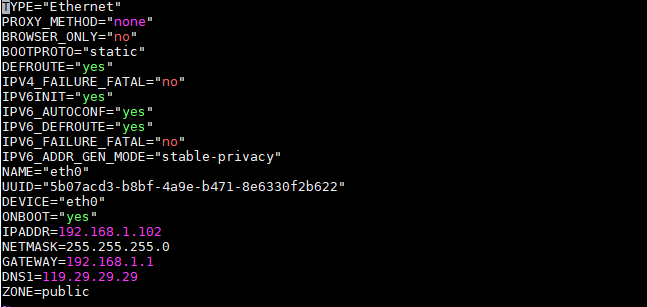

[root@docker]# sudo yum update -y;3.2、配置静态IP

通常在/etc/sysconfig/network-scripts目录下都会有 ifcfg-eth0 格式文件,修改该文件内容:

[root@nexus ~]# vim /etc/sysconfig/network-scripts/ifcfg-eth0

主要修改BOOTPROTO="static"、ONBOOT="yes",并增加 IPADDR、NETMASK、GATEWAY、DNS1。

TYPE="Ethernet"

PROXY_METHOD="none"

BROWSER_ONLY="no"

BOOTPROTO="static"

DEFROUTE="yes"

IPV4_FAILURE_FATAL="no"

IPV6INIT="yes"

IPV6_AUTOCONF="yes"

IPV6_DEFROUTE="yes"

IPV6_FAILURE_FATAL="no"

IPV6_ADDR_GEN_MODE="stable-privacy"

NAME="eth0"

UUID="5b07acd3-b8bf-4a9e-b471-8e6330f2b622"

DEVICE="eth0"

ONBOOT="yes"

IPADDR=192.168.1.102

NETMASK=255.255.255.0

GATEWAY=192.168.1.1

DNS1=119.29.29.29

ZONE=public重启网卡

[root@nexus ~]# service network restart3.3、关闭防火墙

常用命令

[root@nexus]# systemctl start firewalld 启动

[root@nexus]# systemctl stop firewalld 关闭

[root@nexus]# systemctl status firewalld 查看状态

[root@nexus]# systemctl disable firewalld 开机禁用

[root@nexus]# systemctl enable firewalld 开机启用三、K8s 基础配置(在 master 节点和 worker 节点都要执行)

1、安装 Docker

将以下代码框中所有内容(包括 #及其后的备注)一次性拷贝到 centos 命令行终端执行

# 在 master 节点和 worker 节点都要执行

# step 1: 卸载旧版本Docker软件

sudo yum remove -y docker \

docker-ce-cli \

docker-client \

docker-client-latest \

docker-common \

docker-latest \

docker-latest-logrotate \

docker-logrotate \

docker-selinux \

docker-engine-selinux \

docker-engine \

container*;

# step 2: 安装必要的一些系统工具

sudo yum install -y yum-utils \

device-mapper-persistent-data \

lvm2 bash-completion;

# Step 3: 添加软件源信息

sudo yum-config-manager \

--add-repo \

https://mirrors.aliyun.com/docker-ce/linux/centos/docker-ce.repo

# Step 4: 更新并安装 Docker-CE

sudo yum makecache

sudo yum install -y docker-ce-18.09.7 docker-ce-cli-18.09.7 containerd.io

sudo systemctl enable docker

sudo systemctl start docker

# 检查 docker 版本

sudo docker version2、安装 nfs-utils

执行安装命令

# 在 master 节点和 worker 节点都要执行

$ sudo yum install -y nfs-utils必须先安装 nfs-utils 才能挂载 nfs 网络存储

注意!注意!注意!到此处Kubernetes依赖的基础环境已经安装完成,如果采用Rancher作为管理平台,下面的内容仅供了解,不要执行相关命令!!!!

3、安装 kubectl / kubeadm / kubelet

将以下代码框中所有内容(包括 #及其后的备注)一次性拷贝到 centos 命令行终端执行

# 在 master 节点和 worker 节点都要执行

# 关闭 防火墙

systemctl stop firewalld

systemctl disable firewalld

# 关闭 SeLinux

setenforce 0

sed -i "s/SELINUX=enforcing/SELINUX=disabled/g" /etc/selinux/config

# 关闭 swap

swapoff -a

yes | cp /etc/fstab /etc/fstab_bak

cat /etc/fstab_bak |grep -v swap > /etc/fstab

# 修改 /etc/sysctl.conf

# 如果有配置,则修改

sed -i "s#^net.ipv4.ip_forward.*#net.ipv4.ip_forward=1#g" /etc/sysctl.conf

sed -i "s#^net.bridge.bridge-nf-call-ip6tables.*#net.bridge.bridge-nf-call-ip6tables=1#g" /etc/sysctl.conf

sed -i "s#^net.bridge.bridge-nf-call-iptables.*#net.bridge.bridge-nf-call-iptables=1#g" /etc/sysctl.conf

# 可能没有,追加

echo "net.ipv4.ip_forward = 1" >> /etc/sysctl.conf

echo "net.bridge.bridge-nf-call-ip6tables = 1" >> /etc/sysctl.conf

echo "net.bridge.bridge-nf-call-iptables = 1" >> /etc/sysctl.conf

# 执行命令以应用

sysctl -p

# 配置K8S的yum源

cat <<EOF > /etc/yum.repos.d/kubernetes.repo

[kubernetes]

name=Kubernetes

baseurl=http://mirrors.aliyun.com/kubernetes/yum/repos/kubernetes-el7-x86_64

enabled=1

gpgcheck=0

repo_gpgcheck=0

gpgkey=http://mirrors.aliyun.com/kubernetes/yum/doc/yum-key.gpg

http://mirrors.aliyun.com/kubernetes/yum/doc/rpm-package-key.gpg

EOF

# 安装kubelet、kubeadm、kubectl

yum install -y kubelet-1.15.2 kubeadm-1.15.2 kubectl-1.15.2

# 修改docker Cgroup Driver为systemd

# # 将/usr/lib/systemd/system/docker.service文件中的这一行 ExecStart=/usr/bin/dockerd -H fd:// --containerd=/run/containerd/containerd.sock

# # 修改为 ExecStart=/usr/bin/dockerd -H fd:// --containerd=/run/containerd/containerd.sock --exec-opt native.cgroupdriver=systemd

# 如果不修改,在添加 worker 节点时可能会碰到如下错误

# [WARNING IsDockerSystemdCheck]: detected "cgroupfs" as the Docker cgroup driver. The recommended driver is "systemd".

# Please follow the guide at https://kubernetes.io/docs/setup/cri/

sed -i "s#^ExecStart=/usr/bin/dockerd.*#ExecStart=/usr/bin/dockerd -H fd:// --containerd=/run/containerd/containerd.sock --exec-opt native.cgroupdriver=systemd#g" /usr/lib/systemd/system/docker.service

# 设置 docker 镜像,提高 docker 镜像下载速度和稳定性

# 如果您访问 https://hub.docker.io 速度非常稳定,亦可以跳过这个步骤

curl -sSL https://get.daocloud.io/daotools/set_mirror.sh | sh -s http://f1361db2.m.daocloud.io

# 重启 docker,并启动 kubelet

systemctl daemon-reload

systemctl restart docker

systemctl enable kubelet && systemctl start kubeletkubectl包括自动补全支持,可以节省大量的输入!完成脚本本身由kubectl生成,因此您通常只需要从配置文件中调用它。这里提供了常见的例子。有关详细信息,请咨询kubectl completion -h。

在CentOS Linux上,您可能需要安装默认情况下未安装的bash-completion软件包。

yum install bash-completion -y运行source <(kubectl completion bash)可将kubectl自动补全添加到当前shell,要使kubectl自动补全命令自动加载:

echo "source <(kubectl completion bash)" >> ~/.bashrc4、加载 kubernetes 镜像

拉取k8s相关镜像

docker pull mirrorgooglecontainers/kube-apiserver:v1.15.2

docker pull mirrorgooglecontainers/kube-controller-manager:v1.15.1

docker pull mirrorgooglecontainers/kube-scheduler:v1.15.1

docker pull mirrorgooglecontainers/kube-proxy:v1.15.2

docker pull mirrorgooglecontainers/pause:3.1

docker pull mirrorgooglecontainers/etcd:3.3.10

docker pull coredns/coredns:1.6.2在第一步至第三步中,已经搭建好了K8s的基础环境,新建集群也基本项目,建议制作镜像,以备其他节点复用。

四、初始化 Master 节点

- 以 root 身份在 k8s-master 机器上执行

- 初始化 master 节点时,如果因为中间某些步骤的配置出错,想要重新初始化 master 节点,请先执行 kubeadm reset 操作

1、配置 apiserver.k8s 的域名

# 只在 master 节点执行

echo "x.x.x.x apiserver.k8s" >> /etc/hosts请替换其中的 x.x.x.x 为您的 k8s-master 的实际 ip 地址。(如果 k8s-master 同时有内网IP和外网IP,此处请使用内网IP); apiserver.k8s 可根据情况进行调整

2、创建 ./kubeadm-config.yaml

# 只在 master 节点执行

cat <<EOF > ./kubeadm-config.yaml

apiVersion: kubeadm.k8s.io/v1beta1

kind: ClusterConfiguration

kubernetesVersion: v1.15.2

imageRepository: registry.cn-hangzhou.aliyuncs.com/google_containers

controlPlaneEndpoint: "apiserver.k8s:6443"

networking:

podSubnet: "10.100.0.1/20"

EOFpodSubnet 所使用的网段不能与 master节点/worker节点 所在的网段重叠

该字段的取值为一个 CIDR 值,如果您对 CIDR 这个概念还不熟悉,请不要修改这个字段的取值 10.100.0.1/20

3、初始化 apiserver

# 只在 master 节点执行

kubeadm init --config=kubeadm-config.yaml --upload-certs根据您服务器网速的情况,您需要等候 3 - 10 分钟

执行结果如下所示:

Your Kubernetes control-plane has initialized successfully!

To start using your cluster, you need to run the following as a regular user:

mkdir -p $HOME/.kube

sudo cp -i /etc/kubernetes/admin.conf $HOME/.kube/config

sudo chown $(id -u):$(id -g) $HOME/.kube/config

You should now deploy a pod network to the cluster.

Run "kubectl apply -f [podnetwork].yaml" with one of the options listed at:

https://kubernetes.io/docs/concepts/cluster-administration/addons/

You can now join any number of the control-plane node running the following command on each as root:

kubeadm join apiserver.k8s:6443 --token t4i9nf.23h3hvo8ap9cvl2b \

--discovery-token-ca-cert-hash sha256:87dcc006714975f1cc9dad7a1ffb289a50a22224c1caac1b48913a3519625d07 \

--control-plane --certificate-key 23f01b379ecdd3f091b78f4e556d97a02741c68391defc674a0b93ce5b95169b

Please note that the certificate-key gives access to cluster sensitive data, keep it secret!

As a safeguard, uploaded-certs will be deleted in two hours; If necessary, you can use

"kubeadm init phase upload-certs --upload-certs" to reload certs afterward.

Then you can join any number of worker nodes by running the following on each as root:

kubeadm join apiserver.k8s:6443 --token t4i9nf.23h3hvo8ap9cvl2b \

--discovery-token-ca-cert-hash sha256:87dcc006714975f1cc9dad7a1ffb289a50a22224c1caac1b48913a3519625d074、初始化 root 用户的 kubectl 配置

# 只在 master 节点执行

rm -rf /root/.kube/

mkdir /root/.kube/

cp -i /etc/kubernetes/admin.conf /root/.kube/config5、安装 calico

5.1、安装calico, 请参考https://docs.projectcalico.org/v3.6/getting-started/kubernetes/

# 只在 master 节点执行

kubectl apply -f https://docs.projectcalico.org/master/manifests/calico.yaml

#其他版本

kubectl apply -f https://docs.projectcalico.org/v3.6/getting-started/kubernetes/installation/hosted/kubernetes-datastore/calico-networking/1.7/calico.yaml5.2、等待 calico 安装就绪:

执行如下命令,等待 3-10 分钟,直到所有的容器组处于 Running 状态

# 只在 master 节点执行

watch kubectl get pod -n kube-system -o wide6、检查 master 初始化结果

在 master 节点 k8s-master 上执行

# 只在 master 节点执行

kubectl get nodes五、初始化 worke r节点

1、获得 join命令参数

在 master 节点 k8s-master 节点执行

# 只在 master 节点执行

kubeadm token create --print-join-command可获取kubeadm join 命令及参数,如下所示

# kubeadm token create 命令的输出

kubeadm join apiserver.k8s:6443 --token mpfjma.4vjjg8flqihor4vt --discovery-token-ca-cert-hash sha256:6f7a8e40a810323672de5eee6f4d19aa2dbdb38411845a1bf5dd63485c43d3032、初始化worker

针对所有的 worker 节点执行

# 只在 worker 节点执行

echo "x.x.x.x apiserver.k8s" >> /etc/hosts

kubeadm join apiserver.k8s:6443 --token mpfjma.4vjjg8flqihor4vt --discovery-token-ca-cert-hash sha256:6f7a8e40a810323672de5eee6f4d19aa2dbdb38411845a1bf5dd63485c43d303

- 将 x.x.x.x 替换为 k8s-master 的实际 ip。(如果 k8s-master 同时有内网IP和外网IP,此处请使用内网IP)

- 将 kubeadm join 命令后的参数替换为上一个步骤中实际从 k8s-master 节点获得的参数

3、检查初始化结果

在 master 节点 k8s-master 上执行

# 只在 master 节点执行

kubectl get nodes输出结果如下所示:

[root@demo-master-a-1 ~]# kubectl get nodes

NAME STATUS ROLES AGE VERSION

k8s-master Ready master 5m3s v1.15.2

k8s-worker1 Ready <none> 2m26s v1.15.2

k8s-worker2 Ready <none> 3m56s v1.15.2六、移除 worker 节点

正常情况下,您无需移除 worker 节点,如果添加到集群出错,您可以移除 worker 节点,再重新尝试添加

1、在准备移除的 worker 节点上执行

# 只在 worker 节点执行

kubeadm reset2、在 master 节点 k8s-master 上执行

# 只在 master 节点执行

kubectl delete node k8s-worker(x)

- 将 k8s-worker(x) 替换为要移除的 worker 节点的名字

- worker 节点的名字可以通过在节点 k8s-master 上执行 kubectl get nodes 命令获得

七、安装 Ingress Controller

Ingress官方文档:https://kubernetes.io/docs/concepts/services-networking/ingress/

Ingress Controllers官网介绍:https://kubernetes.io/docs/concepts/services-networking/ingress-controllers/

本文中使用如下部署方式:https://kubernetes.github.io/ingress-nginx/deploy/baremetal/#using-a-self-provisioned-edge

kubernetes支持多种Ingress Controllers,本文推荐使用 https://github.com/nginxinc/kubernetes-ingress

1、在 k8s-master 上执行

# 只在 master 节点执行

kubectl apply -f https://raw.githubusercontent.com/eip-work/eip-monitor-repository/master/dashboard/nginx-ingress.yaml2、配置域名解析

将域名 *.demo.yourdomain.com 解析到 k8s-worker2 的 IP 地址 z.z.z.z (也可以是 k8s-worker1 的地址 y.y.y.y)

3、验证配置

在浏览器访问 a.demo.yourdomain.com,将得到 404 NotFound 错误页面

由于需要申请域名,过程会比较繁琐,有如下两种替代方案:

- 在您的客户端机器(访问部署在K8S上的 web 应用的浏览器所在的机器)设置 hosts 配置;

- 暂时放弃域名的配置,临时使用 NodePort 或者 kubectl port-forward 的方式访问部署在 K8S 上的 web 应用

七、重新安装(异常时)

停用服务,删除旧文件,重新安装

# 在 master 节点执行

systemctl stop docker.service

rm -rf /var/lib/docker

systemctl stop kubelet.service

rm -rf /etc/kubernetes/manifests/kube-apiserver.yaml

rm -rf /etc/kubernetes/manifests/kube-controller-manager.yaml

rm -rf /etc/kubernetes/manifests/kube-scheduler.yaml

rm -rf /etc/kubernetes/manifests/etcd.yaml

rm -rf /var/lib/etcd

rm -rf /etc/kubernetes/kubelet.conf

rm -rf /etc/kubernetes/bootstrap-kubelet.conf

rm -rf /etc/kubernetes/pki/ca.crt# 在 worker 节点执行

systemctl stop docker.service

rm -rf /var/lib/docker

systemctl stop kubelet.service

rm -rf /etc/kubernetes/kubelet.conf

rm -rf /etc/kubernetes/bootstrap-kubelet.conf

rm -rf /etc/kubernetes/pki/ca.crt参考资料

https://kuboard.cn/install/install-k8s.html

https://docs.docker.com/install/linux/docker-ce/centos/

https://docs.docker.com/install/linux/linux-postinstall/

更新时间:2025-11-26 16:56